3дёәд»Җд№ҲдҪҝз”Ё JuiceFS пјҹ

жҺҘдёӢжқҘе°ҶиҜҰз»ҶжҺўжЁЎеһӢйғЁзҪІиҝҷдёҖе…ій”®йҳ¶ж®өзҡ„е…·дҪ“е·ҘдҪң гҖӮдёӢеӣҫеұ•зӨәдәҶжҲ‘们жңҖеҲқйҮҮз”Ёзҡ„жһ¶жһ„пјҢеҚіе°ҶжүҖжңүжЁЎеһӢж–Ү件 пјҢ еҢ…жӢ¬ Python/ target=_blank class=infotextkey>Python д»Јз ҒгҖҒPython дҫқиө–е’Ңжү©еұ•пјҢйғҪжү“еҢ…жҲҗдёҖдёӘ Container ImageпјҢ然еҗҺеңЁ Kubernetes дёҠиҝҗиЎҢ гҖӮ然иҖҢ пјҢ иҝҷдёҖжөҒзЁӢйқўдёҙзқҖд»ҘдёӢжҢ‘жҲҳпјҡ

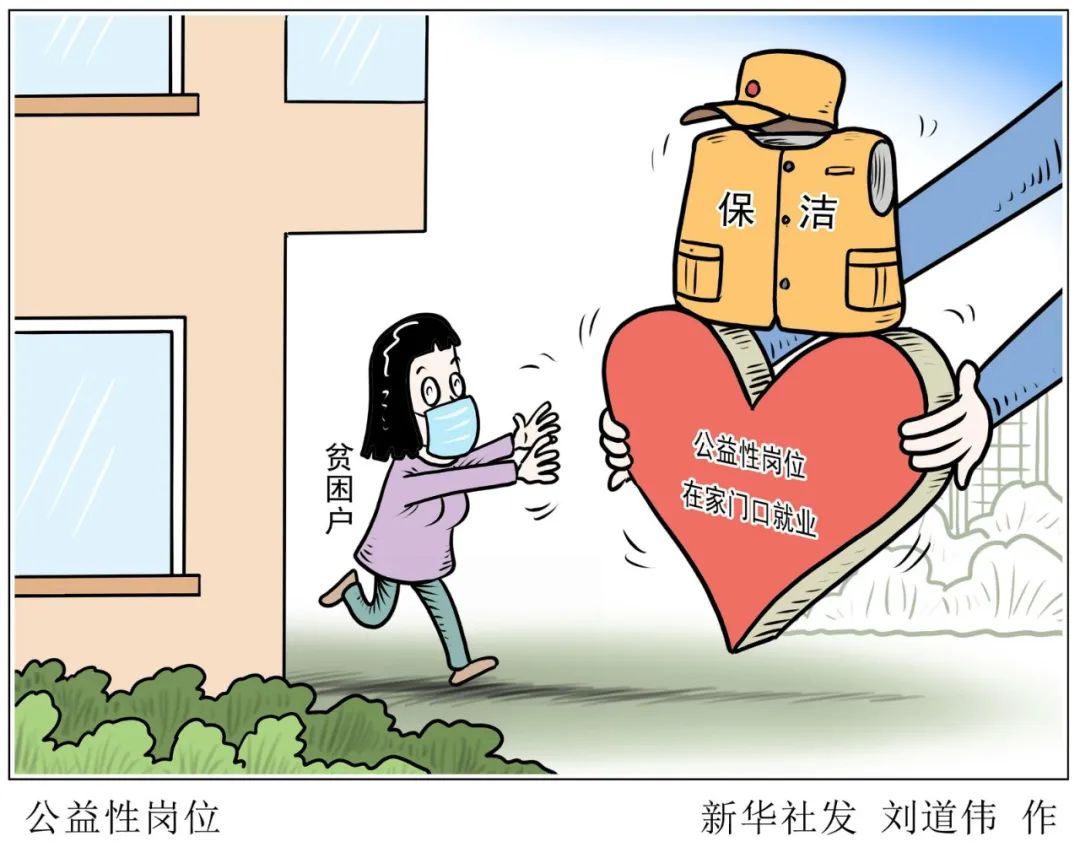

ж–Үз« жҸ’еӣҫ

гҖҗBentoMLпјҡеҰӮдҪ•дҪҝз”Ё JuiceFS еҠ йҖҹеӨ§жЁЎеһӢеҠ иҪҪпјҹгҖ‘пјҲBentoMLпјҡжңҖеҲқжЁЎеһӢйғЁзҪІжөҒзЁӢеӣҫпјү

- йҰ–е…ҲпјҢдёҖдёӘ Container Image з”ұдёҖзі»еҲ— Layer з»„жҲҗпјҢеӣ жӯӨ Container Image жңҖе°Ҹзҡ„дёӢиҪҪе’Ңзј“еӯҳеҚ•дҪҚжҳҜ LayerпјҢиҷҪ然еңЁдёӢиҪҪ Container Image ж—¶пјҢContainer Image зҡ„ Layer жҳҜ并иЎҢдёӢиҪҪзҡ„пјҢдҪҶ Layer еңЁи§ЈеҺӢзҡ„ж—¶еҖҷжҳҜдёІиЎҢзҡ„ гҖӮеҪ“и§ЈеҺӢеҲ°жЁЎеһӢжүҖеңЁзҡ„ Layer ж—¶йҖҹеәҰдјҡеҮҸж…ўпјҢеҗҢж—¶еҚ з”ЁеӨ§йҮҸзҡ„ CPU ж—¶й—ҙ гҖӮ

- еҸҰдёҖдёӘжҢ‘жҲҳжҳҜеҪ“дёҚеҗҢзҡ„ Bento дҪҝз”ЁзӣёеҗҢзҡ„жЁЎеһӢж—¶ гҖӮиҝҷз§Қжһ¶жһ„дјҡжөӘиҙ№еӨҡд»ҪзӣёеҗҢзҡ„з©әй—ҙпјҢ并且被жү“еҢ…еҲ°дёҚеҗҢзҡ„ Image дёӯпјҢдҪңдёәдёҚеҗҢ Layer еӯҳеңЁ пјҢ еҜјиҮҙдәҶеӨҡж¬ЎдёӢиҪҪе’Ңи§ЈеҺӢпјҢиҝҷжҳҜжһҒеӨ§зҡ„иө„жәҗжөӘиҙ№ гҖӮеӣ жӯӨпјҢиҝҷз§Қжһ¶жһ„ж— жі•е…ұдә«жЁЎеһӢ гҖӮ

- йҰ–е…Ҳ пјҢ е®ғйҮҮз”Ё POSIX еҚҸи®®пјҢж— йңҖеҶҚеҠ дёҖеұӮжҠҪиұЎе°ұдҪҝжҲ‘们иғҪеӨҹд»ҘиҝһиҙҜзҡ„ж–№ејҸиҜ»еҸ–ж•°жҚ® гҖӮ

- е…¶ж¬ЎпјҢе®ғеҸҜд»ҘиҫҫеҲ°еҫҲй«ҳзҡ„еҗһеҗҗпјҢеҸҜд»ҘжҺҘиҝ‘ж•ҙдёӘ S3 жҲ– GCS зҡ„еёҰе®Ҫ гҖӮ

- 第дёүпјҢе®ғиғҪеӨҹе®һзҺ°иүҜеҘҪзҡ„е…ұдә«жЁЎеһӢ гҖӮеҪ“жҲ‘们е°ҶжЁЎеһӢеӯҳеӮЁеңЁ JuiceFS дёӯж—¶ пјҢ дёҚеҗҢе®һдҫӢеҸҜд»Ҙе…ұдә«еҗҢдёҖдёӘеӨ§еһӢиҜӯиЁҖжЁЎеһӢ гҖӮ

ж–Үз« жҸ’еӣҫ

пјҲBentoMLпјҡдҪҝз”Ё JuiceFS еҗҺзҡ„жЁЎеһӢйғЁзҪІжөҒзЁӢеӣҫпјү

жӯӨеӨ–пјҢжҲ‘们иҝӣдёҖжӯҘдјҳеҢ–дәҶдёӢиҪҪе’Ңзј“еӯҳзҡ„йў—зІ’еәҰпјҢдёҚд»…жҜҸдёӘжЁЎеһӢйғҪжңүиҮӘе·ұзҡ„зј“еӯҳйў—зІ’еәҰпјҢиҖҢдё” JuiceFS еҜ№еӨ§ж–Ү件еҲҶеүІжҲҗдәҶдёҖзі»еҲ— chunk пјҢ д»Ҙ chunk дёәеҚ•дҪҚиҝӣиЎҢдёӢиҪҪе’Ңзј“еӯҳпјҢеҲ©з”ЁиҝҷдёӘзү№жҖ§еҸҜд»Ҙе®һзҺ°зұ»дјјдәҺеӨ§жЁЎеһӢзҡ„ Stream Loading зҡ„ж•Ҳжһң гҖӮ

жҲ‘们иҝҳе……еҲҶеҲ©з”ЁдәҶ GKE зҡ„ Image Streaming жҠҖжңҜ гҖӮйҖҡиҝҮ Model Streaming е’Ң Image Streaming еҗҢж—¶иҝӣиЎҢж•°жҚ®жӢүеҸ–пјҢжҲ‘们жҲҗеҠҹйҷҚдҪҺдәҶеҗҜеҠЁж—¶й—ҙпјҢжҸҗеҚҮдәҶж•ҙдҪ“жҖ§иғҪ гҖӮ

4йӣҶжҲҗ JuiceFS ж—¶йҒҮеҲ°зҡ„жҢ‘жҲҳ

- жҢ‘жҲҳ 1пјҡж— зјқйӣҶжҲҗ

- жҢ‘жҲҳ 2: еј•е…Ҙ新组件еҜ№дёҡеҠЎйҖ»иҫ‘зҡ„еҪұе“Қ

- жҢ‘жҲҳ 3: JuiceFS дёӢиҪҪйҖҹеәҰй—®йўҳ

5еұ•жңӣ

еңЁжңӘжқҘ пјҢ жҲ‘们е°Ҷж·ұе…ҘиҝӣиЎҢжӣҙеӨҡзҡ„еҸҜи§ӮжөӢжҖ§е·ҘдҪңпјҢд»ҘзЎ®дҝқж•ҙдёӘжһ¶жһ„дҝқжҢҒиүҜеҘҪзҡ„иҝҗиЎҢзҠ¶жҖҒпјҢ并иҺ·еҫ—и¶іеӨҹзҡ„жҢҮж Үд»ҘдҫҝжӣҙеҘҪең°дјҳеҢ–й…ҚзҪ®пјҢе°ҪйҮҸйҒҝе…ҚеҶҚж¬ЎеҮәзҺ°зұ»дјјзҡ„й—®йўҳ гҖӮ

еёҢжңӣеҸҜд»Ҙй«ҳж•ҲеҲ©з”Ё JuiceFS иҮӘеёҰзҡ„зј“еӯҳиғҪеҠӣ гҖӮдҫӢеҰӮпјҢе°ҶжЁЎеһӢжҸҗеүҚз§ҚжӨҚеҲ° JuiceFS еҗҺ пјҢ иҝҷж„Ҹе‘ізқҖеңЁдёҡеҠЎйӣҶзҫӨдёӯпјҢеҸҜд»ҘжҸҗеүҚеңЁиҠӮзӮ№дёӯйў„зғӯжЁЎеһӢзҡ„зј“еӯҳпјҢд»ҺиҖҢиҝӣдёҖжӯҘжҸҗеҚҮзј“еӯҳе’ҢеҶ·еҗҜеҠЁж—¶й—ҙзҡ„жҖ§иғҪ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- Kubernetes йӣҶзҫӨ CPU дҪҝз”ЁзҺҮеҸӘжңү 13% пјҡиҝҷдёӢеӨ§е®¶иҜҘзҹҘйҒ“еҰӮдҪ•зңҒй’ұдәҶ

- еҰӮдҪ•еҹәдәҺDockerй•ңеғҸйҖҶеҗ‘з”ҹжҲҗDockerfile

- дёҖж–Үи§ЈжһҗеҰӮдҪ•еҹәдәҺ LangChain жһ„е»ә LLM еә”з”ЁзЁӢеәҸ

- cdrдёӯзҡ„иЈҒеүӘе·Ҙе…·еә”иҜҘе’ӢдҪҝз”ЁпјҢcdrеӣҫжЎҶзІҫзЎ®иЈҒеүӘеҗҺзңӢдёҚеҲ°еҶ…е®№

- cdrеҰӮдҪ•жүҚиғҪз”»жўҜеҪў

- жңЁиҙЁең°жқҝеҰӮдҪ•дҝқе…»дёҺжё…жҙҒ жңЁиҙЁең°жқҝжҖҺд№Ҳжё…жҙҒ

- иҠұеҚүдё№йЎ¶зәўеҰӮдҪ•е…»ж®– дё№йЎ¶зәўиҠұжҖҺд№Ҳе…»ж®–

- з§ҚжӨҚзүҷжңүдҪҝз”Ёе№ҙйҷҗеҗ—еӨҡе°‘еІҒ з§ҚжӨҚзүҷжңүдҪҝз”Ёе№ҙйҷҗеҗ—

- еҚҺдёәжүӢжңәеҰӮдҪ•еҺ»жҺүи®ҫзҪ®йҮҢзҡ„зәўзӮ№пјҢеҚҺдёәжүӢжңәеҰӮдҪ•еҸ–ж¶Ҳеӣҫж ҮдёҠзәўзӮ№ж•°еӯ—

- ai画笔е·Ҙе…·жҖҺд№Ҳи®©зӮ№иҮӘеҠЁиҝһжҺҘпјҢaiй•ңеғҸе·Ҙе…·еә”иҜҘе’Ӣж»ҙжүҚеҸҜд»ҘдҪҝз”Ё