е…ҲзңӢдёҖдёӘзҪ‘з»ңиҜ·жұӮжҳҜеҰӮдҪ•еҲ°дәҶжҲ‘们зҡ„webе®№еҷЁзҡ„ пјҢ дёҖдёӘзҪ‘з»ңиҜ·жұӮд»Һе®ўжҲ·з«Ҝз»ҸиҝҮиӢҘе№ІзҪ‘зәҝдј иҫ“е’ҢдәӨжҚўжңәи·Ҝз”ұеҷЁзҡ„дёӯй—ҙиҪ¬еҸ‘ пјҢ еҲ°дәҶжҲ‘们зҡ„зҪ‘еҚЎзҡ„ж—¶еҖҷ пјҢ е°ұжҳҜдёҖе Ҷзҡ„й«ҳдҪҺз”өйў‘дҝЎеҸ· пјҢ зҪ‘еҚЎеңЁжҺҘ收еҲ°иҝҷдәӣдҝЎеҸ·еҗҺ пјҢ дјҡжңүдёӘmac+PHYиҠҜзүҮиҝӣиЎҢеӨ„зҗҶ пјҢ йҰ–е…Ҳе°Ҷзү©зҗҶдҝЎеҸ·иҪ¬еҸҳдёәж•°еӯ—дҝЎеҸ· пјҢ еҚі01010101иҝҷж ·дёҖдёІж•°еӯ— пјҢ 然еҗҺиҝӣиЎҢиҪ¬з Ғ пјҢ иҪ¬еҸҳдёәеё§ пјҢ иҝҷе°ұжҳҜзЁӢеәҸеӨ„зҗҶзҪ‘з»ңиҜ·жұӮзҡ„第дёҖдёӘжҰӮеҝө пјҢ д»ҺдёҖдёӘдёӘеё§еҶҚйҖҗжёҗиҪ¬еҸҳжҲҗеҢ… пјҢ д»ҺIPеҢ…еҶҚиҪ¬еҸҳжҲҗTCPеҢ… пјҢ жңҖеҗҺиҪ¬еҸҳжҲҗhttpеҢ… пјҢ иҝҷе°ұжҳҜеӨ§еӯҰеӯҰзҪ‘з»ңйҮҢйқўи®ІиҝҮзҡ„еӣӣеұӮеҚҸи®®жҲ–дёғеұӮеҚҸи®® гҖӮиҝҷдёӘиҝҮзЁӢ пјҢ жңүзҪ‘еҚЎзЎ¬д»¶зҡ„еӨ„зҗҶ пјҢ жңүCPUе’ҢеҶ…еӯҳзҡ„дәӨдә’ пјҢ иҝҳжңүзҪ‘еҚЎй©ұеҠЁе’Ңж“ҚдҪңзі»з»ҹзҡ„зЁӢеәҸжү§иЎҢ гҖӮеҰӮдёӢеӣҫпјҡ

ж–Үз« жҸ’еӣҫ

ж №жҚ®дёҠеӣҫз®ҖеҚ•еҲҶжһҗдёӢзҪ‘з»ңиҜ·жұӮеӨ„зҗҶиҝҮзЁӢпјҡ

- зҪ‘еҚЎжҺҘ收й«ҳдҪҺз”өйў‘дҝЎеҸ·з»ҸиҝҮMACеӨ„зҗҶеҗҺ пјҢ е°Ҷж•°жҚ®еҢ…е…ҲжҡӮеӯҳдәҺзүҮеҶ…FIFOжҺҘ收йҳҹеҲ— гҖӮ

- зҪ‘еҚЎжҺ§еҲ¶еҷЁе°ҶFIFOйҳҹеҲ—ж”ҫе…ҘеҶ…еӯҳзҡ„дёҖдёӘзҺҜеҪўзј“еҶІеҢә гҖӮ

- зҪ‘еҚЎжҺ§еҲ¶еҷЁе°ҶзҺҜеҪўзј“еҶІеҢәзҡ„ж•°жҚ®ж”ҫе…ҘеҶ…еӯҳ пјҢ дёҠеҚҠйғЁеӨ„зҗҶе®ҢжҲҗ гҖӮ

- и§ҰеҸ‘иҪҜдёӯж–ӯ пјҢ ејҖе§ӢдёӢеҚҠйғЁеӨ„зҗҶ гҖӮ

- CPUиҪҜдёӯж–ӯ пјҢ и°ғз”ЁзҪ‘еҚЎй©ұеҠЁзЁӢеәҸ继з»ӯеӨ„зҗҶ гҖӮ

- зҪ‘еҚЎй©ұеҠЁзЁӢеәҸйҖҡиҝҮNAPIејҖе§ӢеӨ„зҗҶеҶ…еӯҳдёӯзҡ„зҪ‘з»ңеҢ… гҖӮ

- ж“ҚдҪңзі»з»ҹеҶ…ж ёзҪ‘з»ңеӨ„зҗҶжЁЎеқ—ејҖе§Ӣд»Ӣе…Ҙ пјҢ жү§иЎҢеӨ§еҗҚйјҺйјҺзҡ„netif_receive_skbеҮҪж•° пјҢ жү§иЎҢе®ҢжҲҗеҗҺ пјҢ зҪ‘з»ңеӨ„зҗҶ第дёҖеӨ§йғЁеҲҶе®ҢжҲҗ пјҢ ејҖе§Ӣиҝӣе…ҘеҚҸи®®еӨ„зҗҶ гҖӮ

- linuxеҶ…ж ёзҡ„socketжЁЎеқ—ејҖе§Ӣд»Ӣе…Ҙ пјҢ иҝӣиЎҢtcpжҲ–udpеҚҸи®®еӨ„зҗҶ гҖӮ

еңЁиҝҷдәӣиҪҜ硬件зӣёдә’дәӨдә’зҡ„иҝҮзЁӢдёӯ пјҢ еӨ§йҮҸеүҚиҫҲй’ҲеҜ№дёӯж–ӯгҖҒж•°жҚ®еҢ…еӨ„зҗҶ пјҢ еҚҸи®®еӨ„зҗҶзӯүеҒҡиҝҮеӨ§йҮҸдјҳеҢ– пјҢ жңүиҪҜзЎ¬дёӯж–ӯгҖҒдёҠеҚҠйғЁдёӢеҚҠйғЁеҲҶзҰ»еӨ„зҗҶгҖҒNAPIгҖҒDMAгҖҒEpollзӯүзӯү пјҢ иҝҷдәӣжҠҖжңҜеҫҲеҘҪзҡ„и§ЈеҶідәҶзҪ‘з»ңиҜ·жұӮеӨ„зҗҶиҝҮзЁӢдёӯзҡ„еҗ„з§Қ瓶йўҲ пјҢ еҸ‘еұ•еҲ°зӣ®еүҚ пјҢ еҮәзҺ°дәҶ100Gbзҡ„зҪ‘еҚЎ пјҢ йҳҝйҮҢе·ҙе·ҙе…ӯе№ҙеүҚе°ұејҖе§Ӣз ”з©¶еҚ•жңәеҚғдёҮиҝһжҺҘ пјҢ еҚіи§ЈеҶіC10Mзҡ„й—®йўҳ пјҢ зӣ®еүҚеңЁзҪ‘з»ңеӨ„зҗҶеұӮйқў пјҢ еҹәжң¬дёҠдёҖеҸ°зү©зҗҶжңәеҸҜд»Ҙж»Ўи¶іжҲ‘们жӯЈеёёзҡ„еҚҒдёҮиҝһжҺҘ并еҸ‘еӨ„зҗҶдәҶ гҖӮе…ідәҺзҪ‘з»ңзј–зЁӢеҶ…е®№д№ҹдёҚжҳҜдёҖеҸҘдёӨеҸҘиғҪиҜҙйҖҸзҡ„ пјҢ жӯӨеӨ„жҡӮдё”еҲҶжһҗеҲ°еҸӘиҰҒдҪҝз”ЁдәҶжӯЈеёёзҡ„дёҖдёӘжңҚеҠЎеҷЁ пјҢ 并且дҪҝз”ЁepollжҠҖжңҜ пјҢ йҖӮеҪ“зҡ„дј°з®—дёӢ并еҸ‘йҮҸе’ҢеёҰе®Ҫ пјҢ зҪ‘з»ңеӨ„зҗҶиҝҷеқ—е„ҝдёҚеӨӘе®№жҳ“жҲҗдёә瓶йўҲ гҖӮдёӢйқўжҲ‘们йҮҚзӮ№иҜҙиҜҙepollе’Ңеә”з”ЁеұӮзҡ„зҪ‘з»ңиҜ·жұӮеӨ„зҗҶ гҖӮ

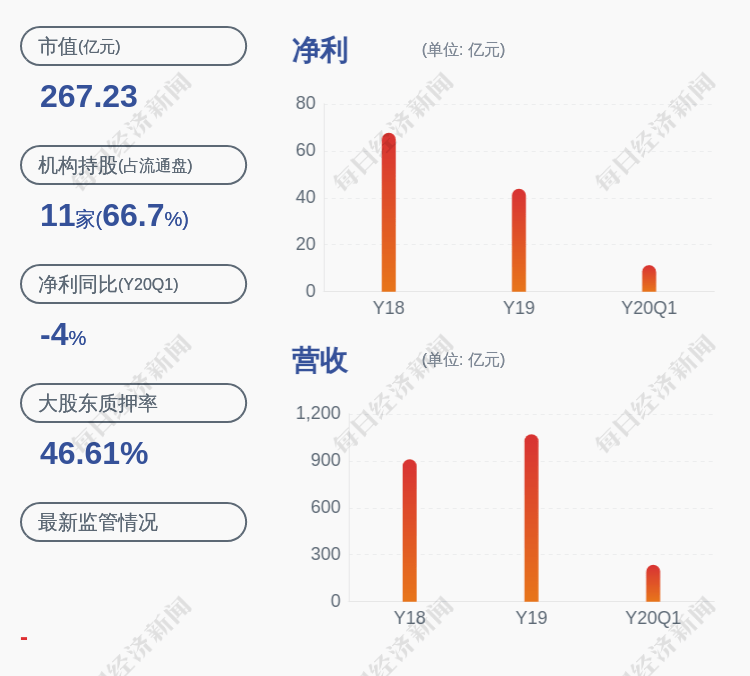

йҰ–е…ҲжҲ‘们еҸҜд»ҘеҒҡдёӘеҹәеҮҶжөӢиҜ• пјҢ е…ҲйҡҸж„ҸжүҫдёҖеҸ°иҷҡжӢҹжңәжңҚеҠЎеҷЁ пјҢ 然еҗҺйғЁзҪІдёӘNginx пјҢ зӣҙжҺҘз”ЁwrkжқҘиҜ•иҜ•еҹәеҮҶжөӢиҜ•зҡ„з»“жһң пјҢ еҸҜд»ҘзңӢеҲ°nginxеңЁдёҖеҸ°еҫҲжҷ®йҖҡзҡ„жңҚеҠЎеҷЁдёҠеҸҜд»Ҙж”Ҝж’‘8дёҮ并еҸ‘ гҖӮеҰӮжһңеңЁиҝҷеҸ°жңҚеҠЎеҷЁеӨҡи·‘еҮ дёӘnginx пјҢ еҹәжң¬дёҠеҸҜд»ҘжҠҠзҪ‘еҚЎжү“ж»Ў пјҢ 并еҸ‘д№ҹеҸҜд»ҘдёҠеҲ°еҚҒеҮ дәҢеҚҒдёҮ пјҢ иҝҷе°ұи·ҹжң¬иә«жңҚеҠЎеҷЁжҖ§иғҪжңүе…ідәҶ пјҢ еҰӮжһңжҳҜдёӘзү©зҗҶжңә пјҢ жҖ§иғҪдјҡжӣҙй«ҳ гҖӮnginxеҸӘжҳҜжөӢиҜ•дәҶдёҖдёӘhttpиҜ·жұӮзҡ„еӨ„зҗҶ并еҸ‘ пјҢ nginxеҹәеҮҶжөӢиҜ•е®ҢжҲҗеҗҺ пјҢ еҸҜд»ҘиҝӣдёҖжӯҘиҝӣиЎҢtomcatзҡ„еҹәеҮҶжөӢиҜ•е’Ңspringbootзҡ„еҹәеҮҶжөӢиҜ• пјҢ жңҖеҗҺдҪҝз”Ёе…¬еҸёеҶ…йғЁзҡ„жЎҶжһ¶еҒҡдёҖдёӘзҪ‘з»ңеӨ„зҗҶзҡ„еҹәеҮҶжөӢиҜ• пјҢ еҫ—еҲ°дёҖдёӘзӣёеҜ№еҗҲзҗҶзҡ„жһҒйҷҗеҖј гҖӮжҲ‘们еҒҡзҡ„з»“жһңжҳҜnginxеҚ•жңәеҸҢе®һдҫӢеҚ з”Ё4ж ёеҸҜд»ҘеҲ°15дёҮ пјҢ tomcatеҸҜд»ҘеҲ°10дёҮ пјҢ springbootе’ҢеҶ…йғЁе°ҒиЈ…еҗҺзҡ„жЎҶжһ¶еҸҜд»ҘеҲ°9дёҮ гҖӮз”ұжӯӨзңӢжқҘwebе®№еҷЁе’ҢspringжЎҶжһ¶еӨҡеӨҡе°‘е°‘дјҡжҚҹиҖ—дёҖдәӣжҖ§иғҪ гҖӮжӯӨж—¶зҡ„瓶йўҲдёәCPU пјҢ еӣ дёәдёҖзӣҙеңЁеӨ„зҗҶзҪ‘з»ңиҜ·жұӮзҡ„收еҸ‘ пјҢ дёҺйў„жңҹзӣёз¬Ұ пјҢ еңЁзҪ‘з»ңеӨ„зҗҶеұӮйқў пјҢ CPUгҖҒзҪ‘еҚЎе’ҢеёҰе®Ҫз»қеҜ№жҳҜ瓶йўҲ гҖӮдёӢеӣҫжҳҜnginxзҡ„еҺӢжөӢз»“жһң гҖӮ

жҺЁиҚҗйҳ…иҜ»

- ж–°ж—¶д»Јзҡ„зҪ‘з»ңе·ҘзЁӢеёҲйңҖиҰҒжҺҢжҸЎе“ӘдәӣжҠҖиғҪ

- е…ідәҺдёҖж¬ЎејұеҸЈд»Өзҡ„BCжё—йҖҸ

- жңұе…ғз’Ӣеҗ‘е…ғжңқз§°иҮЈ,жңұе…ғз’ӢжҖҺд№Ҳжү“иҙҘе…ғжңқзҡ„

- иҜ—д»ҷеӨӘзҷҪжҳҜе“Әжңқзҡ„и‘—еҗҚиҜ—дәә,иҜ—д»ҷеӨӘзҷҪжҳҜе“ӘйҮҢдә§зҡ„

- еҜ№жҹҗeduз«ҷзӮ№зҡ„дёҖж¬Ўжё—йҖҸжөӢиҜ•

- Redis жңүе“Әдәӣж•°жҚ®зұ»еһӢпјҹ

- е°үиҝҹжҒӯдёәд»Җд№ҲеҸ«е°үиҝҹ敬еҫ·,е°үиҝҹ敬еҫ·зҡ„иҜҙжі•

- е®һз”Ё-APIжҺҘеҸЈи®ҫи®Ў

- еҲҳеӨҮжңүиҜёи‘ӣдә®е’Ңдә”иҷҺдёҠе°Ҷдёәе•Ҙдјҡиҫ“,еҲҳеӨҮзҡ„дә”иҷҺдёҠе°ҶжҳҜе“Әдә”иҷҺ

- JavaScript еҰӮдҪ•жЈҖжөӢж–Ү件зҡ„зұ»еһӢпјҹ

![[зҺӢ瑶]иЈҒеҶідәҶпјҒзү№жң—жҷ®ж”ҝеәңиҝқжі•](http://dayu-img.uc.cn/columbus/img/oc/1002/2f44f7485846122ee8150e78bee9aefa.jpg)