з§ҹжҲ·й—ҙи°ғеәҰ/иҫ“е…Ҙе…ұдә« йҷҚдҪҺжҲҗжң¬жңҖйҮҚиҰҒзҡ„жҠҖжңҜжүӢж®өе°ұжҳҜеҒҡдәҶиҫ“е…Ҙе…ұдә« пјҢ иҫ“е…Ҙе…ұдә«еңЁеҫҲеӨҡжғ…еҶөдёӢиғҪеҮҸе°‘иө·з ҒдёүеҖҚжҲ–иҖ…дә”еҖҚзҡ„ж—Ҙеҝ—жӢүеҸ– гҖӮеӣ дёәеңЁеӨҡж•°жғ…еҶөдёӢдёҖдёӘж—Ҙеҝ—дјҡдә§еҮәеӨҡдёӘжҢҮж Ү пјҢ дёҚеҗҢзҡ„жҢҮж Үд№ҹеҸҜиғҪдјҡжү“еҲ°еҗҢдёҖд»Ҫж—Ҙеҝ—йҮҢйқў гҖӮ

жҖҺд№ҲеҒҡе‘ўпјҹBrain жҸҗеүҚжіЁеҶҢдәҶ Reduce пјҢ Reduce жҸҗеүҚжіЁеҶҢдәҶ Map пјҢ Map дёҠжңүдёҖдёӘе…ізі» пјҢ е°ұжҳҜиҝҷдёӘ Map иҰҒйҮҮйӣҶе“ӘдәӣжңәеҷЁдёҠзҡ„е“Әдәӣж—Ҙеҝ— гҖӮжңҖз»ҲеҸҜд»Ҙжһ„е»әеҮәжқҘдёҖдёӘе…ізі»жқҘ пјҢ е°ұжҳҜзӣ‘жҺ§йЎ№и·ҹжңәеҷЁдёҠзҡ„ж—Ҙеҝ—зҡ„еҜ№еә”е…ізі» гҖӮжҜ”еҰӮиҜҙ第дёҖдёӘзӣ‘жҺ§йЎ№иҰҒйҮҮйӣҶ100еҸ°жңәеҷЁдёҠзҡ„жҹҗдёӘж—Ҙеҝ— пјҢ 第дәҢдёӘзӣ‘жҺ§йЎ№иҝҳжҳҜиҰҒйҮҮйӣҶиҝҷжү№жңәеҷЁдёҠзҡ„еҗҢж ·ж—Ҙеҝ— гҖӮиҝҷдёӨдёӘд»»еҠЎе°ұеҗҲ并жҺүдәҶ пјҢ жңҖз»ҲжүҖжңүзҡ„йҮҮйӣҶеҗҢдёҖд»Ҫж—Ҙеҝ—зҡ„д»»еҠЎйғҪдјҡиў«еҗҲ并жҺү пјҢ иҝҷжҳҜжҸҗеүҚжіЁеҶҢйҮҢйқўеҸҜд»ҘеҒҡзҡ„дәӢжғ… гҖӮ

е…ізі»жһ„е»әеҘҪдәҶд»ҘеҗҺ пјҢ е°ұи§ҰеҸ‘дёҖдёӘе®ҡж—¶еҷЁжқҘи§ҰеҸ‘жӢүеҸ– гҖӮ

жё…зҗҶеғөе°ёй…ҚзҪ® жҲ‘д»¬ж №жҚ®жҹҗдёӘй…ҚзҪ®е®ғжңҖиҝ‘дёҖж®өж—¶й—ҙиў«еӨҡе°‘дәәи®ҝй—® пјҢ жңүжІЎжңүжҠҘиӯҰ пјҢ жҠҘиӯҰеҗҺжңүжІЎжңүдәәеӨ„зҗҶ пјҢ зӯүзӯүдёҖзі»еҲ—жҢҮж Үи®Ўз®—еҮәзӣ‘жҺ§йЎ№зҡ„еҒҘеә·еәҰ гҖӮеҰӮжһңеҒҘеә·еәҰеӨӘдҪҺ пјҢ е°ұдјҡйҖҡзҹҘз”ЁжҲ·еҺ»жё…зҗҶе®ғ пјҢ еҮҸе°‘жҲ‘们й…ҚзҪ®йҮҸ гҖӮ

з»ҹи®ЎеҖјдјҳе…Ҳ з»ҹи®ЎеҖјдјҳе…Ҳд№ҹжҳҜзҺ°еңЁдёҚеҫ—дёҚеҒҡзҡ„дёҖдёӘдјҳеҢ– гҖӮеӣ дёәд»ҘеүҚеҫҲеӨҡеә”з”Ёжү“зҡ„йғҪжҳҜжөҒж°ҙзҡ„ж—Ҙеҝ— пјҢ д»ҘдәӨжҳ“дёҫдҫӢ, дәӨжҳ“жңүеҫҲеӨҡзҺҜиҠӮ, жҜҸдёӘзҺҜиҠӮиҮіе°‘жңүдёҖиЎҢж—Ҙеҝ— пјҢ жңҖз»ҲжңүеҸҜиғҪ1дәҝ笔дәӨжҳ“еҜ№еә”100дәҝжқЎж—Ҙеҝ— гҖӮжүҖд»ҘдјҡиҰҒжұӮеӨ§зҡ„дёҡеҠЎж–№ пјҢ жҠҠиҝҷдәӣеҖјж”№жҲҗз»ҹи®ЎеҖј пјҢ иҮіе°‘жҳҜжҜҸз§’жҲ–иҖ…жҜҸеҲҶй’ҹиҒҡеҗҲеҗҺзҡ„еҖјжү“еҮәжқҘ гҖӮ

2.9гҖҒиҫ“е…Ҙе…ұдә«

ж–Үз« жҸ’еӣҫ

еӨҡдёӘй…ҚзҪ®дёҖд»Ҫж—Ҙеҝ—еҸӘйҮҮйӣҶдёҖж¬Ў

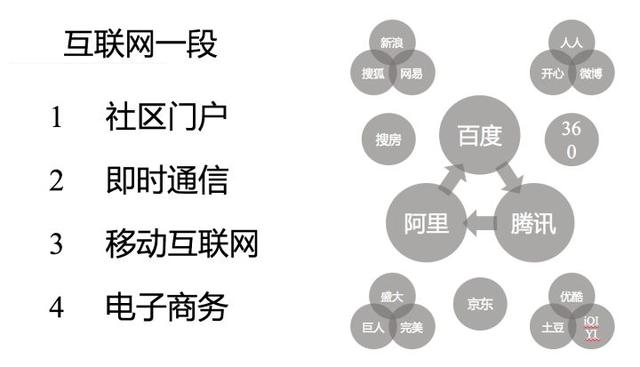

дёүгҖҒжҠҖжңҜйҖүжӢ©

ж–Үз« жҸ’еӣҫ

иҝҷжҳҜжҲ‘们еҒҡзӣ‘жҺ§зҡ„иҝҮзЁӢдёӯеҒҡзҡ„дёҖдәӣжҠҖжңҜйҖүжӢ© гҖӮжӢүе’ҢжҺЁжЁЎејҸеҗ„жңүдјҳзјәзӮ№ пјҢ дёәдәҶеҮҶзЎ®жҖ§йҖүжӢ©дәҶжӢүзҡ„жЁЎејҸ пјҢ дёҚжҺ’йҷӨжҺЁзҡ„жЁЎејҸд№ҹиғҪжҗһе®ҡеҮҶзЎ®жҖ§ пјҢ иҝҳжҳҜдјҡиө°еҲ°жҺЁзҡ„и·ҜзәҝдёҠжқҘ пјҢ еӣ дёәжһ¶жһ„жҖ»жҳҜдёҚж–ӯиҝӯд»Јзҡ„ гҖӮ

и®Ўз®—еә”иҜҘеңЁ Server з«ҜиҝҳжҳҜ Agent з«Ҝжү§иЎҢе‘ўпјҹеӣ дёәз”ЁжҲ·жҺҘеҸ—дёҚдәҶ CPU дҪҝз”ЁзҺҮиҝҮй«ҳ пјҢ дјҡеҪұе“ҚжӯЈеёёдёҡеҠЎ пјҢ еӣ жӯӨжҲ‘们жңҖз»ҲйҖүжӢ©жүҖжңүзҡ„и®Ўз®—йғҪеңЁ Server з«Ҝе®ҢжҲҗ гҖӮ

еҜ№дәҺдҪҝз”ЁејҖжәҗжЎҶжһ¶иҝҳжҳҜиҮӘз ”жЎҶжһ¶ пјҢ жҲ‘们д№ҹеёҢжңӣз”ЁејҖжәҗжЎҶжһ¶ пјҢ дҪҶеҰӮжһңжңүзҡ„ең°ж–№ж»Ўи¶ідёҚдәҶжҲ–иҖ…ејҖжәҗзӨҫеҢәзҡ„ж–№еҗ‘и·ҹжҲ‘们жңҹжңӣзҡ„ж–№еҗ‘дёҚеӨӘдёҖиҮҙ пјҢ жҲ‘们еҸҜиғҪе°ұдјҡеҹәдәҺиҝҷдёӘжЎҶжһ¶зҡ„жҖқжғіе®ҡеҲ¶дёҖдёӘз®Җжҳ“зҡ„ гҖӮеҸӘжңүж ёеҝғзҡ„и®ҫи®Ў пјҢ д»Јз ҒдҪ“йҮҸе°Ҹз»ҙжҠӨд№ҹз®ҖеҚ• пјҢ е…¶е®һжҲ‘们计算жЎҶжһ¶еҒҡеҮәжқҘд»ҘеҗҺ пјҢ еҮ д№ҺжІЎжңүдә§з”ҹиҝҮд»Җд№Ҳ BUG пјҢ еӣ еӨ–е®ғеҸӘеҒҡдәҶж¶ҲжҒҜеҲҶеҸ‘зәҝзЁӢжұ з®ЎзҗҶе’Ңж•…йҡңе®ҲжҠӨиҝҷеҮ 件дәӢжғ… гҖӮ

еңЁж•°жҚ®еә“йҖүжӢ©дёҠ пјҢ еҪ“еүҚжҲ‘们жҳҜзӣҙжҺҘеҶҷ Hbase пјҢ жӯЈеңЁе’Ң HiTSDB еӣўйҳҹеҜ№жҺҘ, иҝҷжҳҜдёҖдёӘзұ» OpenTSDB зҡ„еӯҳеӮЁ, еңЁйҳҝйҮҢдә‘дёҠд№ҹжңүжҸҗдҫӣ гҖӮ

еҜ№дәҺзӣ‘жҺ§жқҘиҜҙ пјҢ жҲ‘们жңҖз»ҲйҖүжӢ©зҡ„иҮӘиҝҗз»ҙ пјҢ жҲ‘们еҮ д№ҺжІЎжңүејәдҫқиө–д»»дҪ•зі»з»ҹ гҖӮдёәд»Җд№Ҳе‘ўпјҹеӣ дёәжҲ‘们жңүдёӘзҗҶеҝө пјҢ зӣ‘жҺ§еә”иҜҘжҳҜжңҖеҹәзЎҖзҡ„и®ҫж–Ҫ пјҢ еҰӮжһңжҲ‘们ејәдҫқиө–еҲ«дәә пјҢ жҲ‘们зӣ‘жҺ§дёҚдәҶе®ғ пјҢ жүҖд»ҘжҲ‘们еҒҡдәҶдёҖдёӘиҮӘиҝҗз»ҙдҪ“зі» гҖӮ

д»ҘдёҠе°ұжҳҜеҒҡзҡ„дёҖдәӣжҠҖжңҜйҖүжӢ© пјҢ з»ҸиҝҮдәҶеҫҲеӨҡж¬Ўиҝӯд»Ј пјҢ жңҖз»Ҳиө°еҲ°дәҶзҺ°еңЁзҡ„и·Ҝзәҝ гҖӮ

еӣӣгҖҒж–№еҗ‘

зҺ°еңЁжҲ‘们зҡ„ж–№еҗ‘жҳҜиҝҷеӣӣдёӘпјҡ

1.ж ҮеҮҶеҢ–

2.дёҖдҪ“еҢ–

3.жңҚеҠЎеҢ–

4.жҷәиғҪеҢ–

4.1гҖҒж ҮеҮҶеҢ–: MQL

select avg(cpu.util),max(load.load1) from system where App='AppTest' since 30mselect * from sunfire.1005_SM_13 since 30mselect * from spring filter class='classA' and method='methodB' where ip='192.168.1.1' since 1h

жҲ‘们еҸ« MQL пјҢ жҲ‘们зҡ„ MQL еёҢжңӣи®©з”ЁжҲ·иғҪеӨҹз”ЁдёҖдёӘйҖҡз”Ёзҡ„иҜӯжі•жқҘжҹҘиҜўжүҖжңүзҡ„зӣ‘жҺ§ж•°жҚ® гҖӮз”ҡиҮіжҳҜе…¶д»–зӣ‘жҺ§зі»з»ҹзҡ„ж•°жҚ® пјҢ иҝҷж ·з”ЁжҲ·дёҚз”Ёз®Ўж•°жҚ®жҳҜе“ӘдёӘе№іеҸ°дә§з”ҹзҡ„ гҖӮMQL еңЁдҪҝз”ЁдёҠд№ҹжҜ”еҺҹжқҘзҡ„ API жӣҙзӣҙи§ӮдёҖдәӣ пјҢ дјҡжҳҜжҲ‘们еҗҺйқўдё»жҺЁзҡ„жҸҗдҫӣз»ҷз”ЁжҲ· API зҡ„ж–№ејҸ гҖӮ

4.2гҖҒдёҖдҪ“еҢ–

ж–Үз« жҸ’еӣҫ

жҲ‘们иҝҳеҒҡдәҶеҫҲеӨҡдёҖдҪ“еҢ–зҡ„дәӢжғ… пјҢ жҜ”еҰӮиҜҙеҸ‘зҺ°дәӨжҳ“дёӢи·ҢдәҶ пјҢ иҝҷж—¶еҖҷдәӨжҳ“зҡ„еә”з”ЁжңүжІЎжңүеҒҡеҸҳжӣҙ пјҢ жңүжІЎжңүжү©е®№гҖҒзј©е®№йҮҚеҗҜзҡ„ж“ҚдҪң пјҢ иҝҷжҳҜз”ЁжҲ·е…іеҝғзҡ„ гҖӮжҲ‘们з»ҹи®ЎеҮәжқҘжңүзӣёеҪ“жҜ”дҫӢзҡ„ж•…йҡңжҳҜеӣ дёәеҸҳжӣҙеҜјиҮҙзҡ„ пјҢ еҪ“дёҡеҠЎејӮеёёзҡ„ж—¶еҖҷзӣҙи§Ӯзҡ„зңӢеҲ°жңүжІЎжңүеҸҳжӣҙ пјҢ еҸҜд»Ҙдёәд»–зңҒеҫҲеӨҡж—¶й—ҙ гҖӮиҷҪ然иҝҷдёӘдәӢжғ…еҒҡиө·жқҘеҫҲз®ҖеҚ• пјҢ дҪҶжҳҜдҪңз”ЁжҳҜеҫҲеӨ§зҡ„ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- йҳҝйҮҢејҖжәҗзҡ„еҲҶеёғејҸдәӢеҠЎжЎҶжһ¶ Seata

- еҰӮдҪ•дҪҝз”Ё Python жқҘиҮӘеҠЁдәӨжҳ“еҠ еҜҶиҙ§еёҒ

- дёҖдёҮдәҝе№ҙеҗҺзҡ„ең°зҗғ дёҖдәҝе№ҙеҗҺзҡ„ең°зҗғ

- йҳҝйҮҢе·ҙе·ҙ|е“Ҳе•°еҮәиЎҢжӣҙжҚўж–°logo зҪ‘еҸӢпјҡи®ҫи®ЎиҠұдәҶеӨҡе°‘й’ұпјҹ

- иңңиҢ¶жў—еҰӮдҪ•е–қ,жҷ®жҙұиҢ¶еҰӮдҪ•еҲҶзұ»

- 100дёҮдәҝе№ҙеҗҺзҡ„ең°зҗғ ең°зҗғеҚҒдәҝе№ҙеҗҺ

- йҳҝйҮҢдә‘гҖҒи…ҫи®Ҝдә‘гҖҒзӯүдә‘жңҚеҠЎеҷЁжңүд»Җд№ҲеҢәеҲ«

- playstation|иҒҢй—®пҪңйҳҝйҮҢж ЎжӢӣи–Әиө„жӣқе…үпјҒеә”еұҠз”ҹе…ҘиҒҢе№ҙи–Ә63wпјҢзңӢе®ҢеІ—дҪҚиҰҒжұӮжҲ‘йә»дәҶ...

- дәӨжҳ“|е’Ңз”°зҺүзҡ„д»·еҖјпјҢдҪ жҳҜжҖҺж ·еҲӨж–ӯзҡ„пјҢдәӨжҳ“иғҪз Қд»·еҗ—пјҹ

- еӨӘйҳізі»дҪ“з§ҜжңҖеӨ§зҡ„жҳҹзҗғ еӨ§зҠ¬еә§vyжҳҜеӨӘйҳізҡ„дёҖдёҮдәҝеҖҚ