иҝҳеҸҜд»ҘйҖҡиҝҮжҲ‘们зҡ„SystemTapи„ҡжң¬жқҘи§ӮеҜҹиҝҷдёӘж•°жҚ®пјҡ resq.stp

еҒҮеҰӮзЁӢеәҸи°ғз”Ёaccept()дёҚеӨҹеҝ«пјҹ

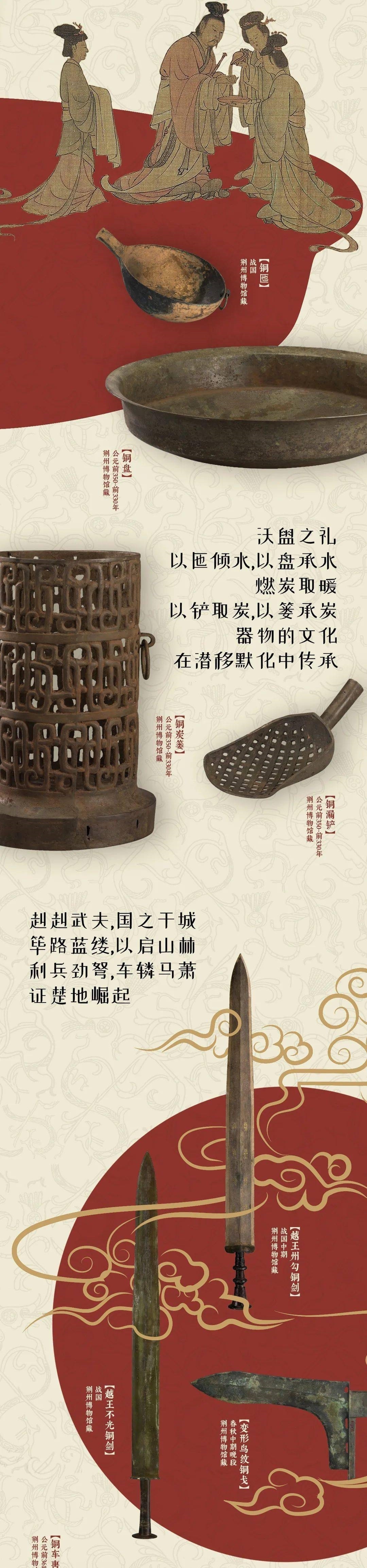

ж–Үз« жҸ’еӣҫ

еҰӮжһңзЁӢеәҸи°ғз”Ёaccept()дёҚеӨҹеҝ«дјҡеҸ‘з”ҹд»Җд№Ҳе‘ўпјҹ

TcpExtListenOverflows / LINUX_MIB_LISTENOVERFLOWSTcpExtListenDrops / LINUX_MIB_LISTENDROPSеҸ‘з”ҹиҝҷз§Қжғ…еҶөж—¶ пјҢ жҲ‘们еҸӘиғҪеҜ„еёҢжңӣдәҺзЁӢеәҸзҡ„еӨ„зҗҶжҖ§иғҪзЁҚеҗҺиғҪжҒўеӨҚжӯЈеёё пјҢ е®ўжҲ·з«ҜйҮҚж–°еҸ‘йҖҒиў«жңҚеҠЎз«Ҝдёўејғзҡ„еҢ… гҖӮ

еҶ…ж ёзҡ„иҝҷз§ҚиЎЁзҺ°еҜ№дәҺеӨ§йғЁеҲҶжңҚеҠЎжқҘиҜҙжҳҜеҸҜжҺҘеҸ—зҡ„ гҖӮйЎәдҫҝдёҖжҸҗ пјҢ еҸҜд»ҘйҖҡиҝҮи°ғж•ҙ net.ipv4.tcp_abort_on_overflow иҝҷдёӘе…ЁеұҖеҸӮж•°жқҘдҝ®ж”№иҝҷз§ҚиЎЁзҺ° пјҢ дҪҶжҳҜжңҖеҘҪиҝҳжҳҜдёҚиҰҒж”№иҝҷдёӘеҸӮж•° гҖӮ

еҸҜд»ҘйҖҡиҝҮжҹҘзңӢnstatзҡ„и®Ўж•°жқҘи§ӮеҜҹAcceptйҳҹеҲ—жәўеҮәзҡ„зҠ¶жҖҒпјҡ

$ nstat -az TcpExtListenDropsTcpExtListenDrops 49199 0.0дҪҶжҳҜиҝҷжҳҜдёҖдёӘе…ЁеұҖзҡ„и®Ўж•° гҖӮи§ӮеҜҹиө·жқҘдёҚеӨҹзӣҙи§Ӯ пјҢ жҜ”еҰӮжңүж—¶жҲ‘们и§ӮеҜҹеҲ°е®ғеңЁеўһй•ҝ пјҢ дҪҶжҳҜжүҖжңүзҡ„жңҚеҠЎзЁӢеәҸзңӢиө·жқҘйғҪжҳҜжӯЈеёёзҡ„ гҖӮжӯӨж—¶жҲ‘们еҸҜд»ҘдҪҝз”Ёssе‘Ҫд»ӨжқҘи§ӮеҜҹеҚ•дёӘзӣ‘еҗ¬з«ҜеҸЈзҡ„AcceptйҳҹеҲ—еӨ§е°Ҹпјҡ

$ ss -plnt sport = :6443|catState Recv-Q Send-Q Local Address:Port Peer Address:PortLISTEN 0 1024 *:6443 *:*Recv-Q иҝҷдёҖеҲ—жҳҫзӨәзҡ„жҳҜеӨ„дәҺAcceptйҳҹеҲ—дёӯзҡ„socketж•°йҮҸ пјҢ Send-Q жҳҫзӨәзҡ„жҳҜйҳҹеҲ—зҡ„жңҖеӨ§еӨ§е°Ҹ гҖӮеңЁдёҠйқўзҡ„дҫӢеӯҗдёӯ пјҢ жҲ‘们еҸ‘зҺ°е№¶жІЎжңүжңӘиў«зЁӢеәҸaccept()зҡ„socket пјҢ дҪҶжҳҜжҲ‘们дҫқ然еҸ‘зҺ°ListenDropsи®Ўж•°еңЁеўһй•ҝ гҖӮ

иҝҷжҳҜеӣ дёәжҲ‘们зҡ„зЁӢеәҸеҸӘжҳҜе‘ЁжңҹжҖ§зҡ„зҹӯжҡӮеҚЎдҪҸдёҚеӨ„зҗҶж–°зҡ„иҝһжҺҘ пјҢ иҖҢйқһж°ёд№…жҖ§зҡ„дёҚеӨ„зҗҶ пјҢ иҝҮж®өж—¶й—ҙзЁӢеәҸеҸҲжҒўеӨҚдәҶжӯЈеёё гҖӮиҝҷз§Қжғ…еҶөдёӢ пјҢ з”Ёssе‘Ҫд»ӨжҜ”иҫғйҡҫи§ӮеҜҹиҝҷз§ҚзҺ°иұЎ пјҢ еӣ жӯӨжҲ‘们еҶҷдәҶдёҖдёӘ SystemTapи„ҡжң¬ пјҢ е®ғдјҡhookиҝӣеҶ…ж ё пјҢ жҠҠиў«дёўејғзҡ„SYNеҢ…жү“еҚ°еҮәжқҘпјҡ

$ sudo stap -v acceptq.stptime (us) acceptq qmax local addr remote_addr1495634198449075 1025 1024 0.0.0.0:6443 10.0.1.92:285851495634198449253 1025 1024 0.0.0.0:6443 10.0.1.92:505001495634198450062 1025 1024 0.0.0.0:6443 10.0.1.92:65434...йҖҡиҝҮдёҠйқўзҡ„ж“ҚдҪң пјҢ еҸҜд»Ҙи§ӮеҜҹеҲ°е“ӘдәӣSYNеҢ…иў«ListenDropsеҪұе“ҚдәҶ гҖӮд»ҺиҖҢжҲ‘们д№ҹе°ұеҸҜд»ҘзҹҘйҒ“е“ӘдәӣзЁӢеәҸеңЁдёўеӨұиҝһжҺҘ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- жҡ–ж°”зүҮжё…жҙ—д№ӢеҗҺжңүд»Җд№ҲйңҖиҰҒжіЁж„Ҹзҡ„,жҡ–ж°”зүҮжё…жҙ—иҰҒеҠ жё…жҙ—еүӮеҗ—

- еҲҶдә«6 ж¬ҫйқўеҗ‘LinuxжңҚеҠЎеҷЁзҡ„ејҖжәҗз»ҳеӣҫеә”з”ЁзЁӢеәҸ

- OSIдёғеұӮжЁЎеһӢжҜҸеұӮзҡ„дҪңз”ЁпјҢи¶…иҜҰз»Ҷ

- з“·з –дёҠзҡ„иӮҘзҡӮеһўжҖҺд№ҲеҠһ,еҚ«з”ҹй—ҙзҺ»з’ғдёҠзҡ„иӮҘзҡӮж°ҙжҖҺд№Ҳжҙ—

- ж— зәҝи·Ҝз”ұеҷЁгҖҒAPгҖҒиғ–APгҖҒзҳҰAPзҡ„жҰӮеҝөеҢәеҲ«

- з©әи°ғеӨ–жңәдёҚиҪ¬жҳҜеҺӢзј©жңәеқҸдәҶеҗ—,з©әи°ғеӨ–жңәдёҚиҪ¬жҳҜеҺӢзј©жңәзҡ„й—®йўҳеҗ—

- McAfeeжқҖжҜ’иҪҜ件дёӯзҡ„жҸҗжқғжјҸжҙһ

- йӣӘиҠұз§ҖйҖӮеҗҲеӨҡеӨ§е№ҙйҫ„зҡ„дәәдҪҝз”Ё йӣӘиҠұз§ҖйҖӮеҗҲд»Җд№Ҳе№ҙйҫ„з”Ё?е…Ёзі»еҲ—д»Ӣз»Қ

- дҪ дёҖе®ҡиҰҒзҹҘйҒ“пјҢе…ідәҺhttpsзҡ„дә”еӨ§иҜҜеҢә

- дё–з•ҢжңҖеӨ§зҡ„ж·Ўж°ҙж№–жіҠзҫӨ дё–з•ҢжңҖеӨ§зҡ„ж·Ўж°ҙж№–зҫӨжҳҜд»Җд№Ҳж№–