Day212:и®әж–Үзҝ»иҜ‘

гҖҗDay212:и®әж–Үзҝ»иҜ‘гҖ‘Orientation-aware Vehicle Re-identification with Semantics-guided Part Attention Network

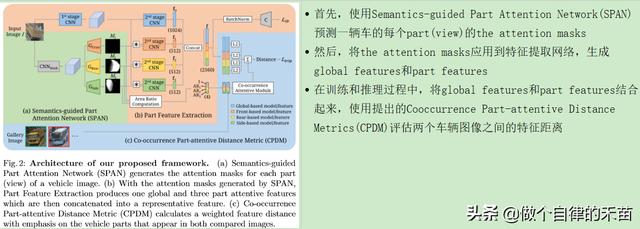

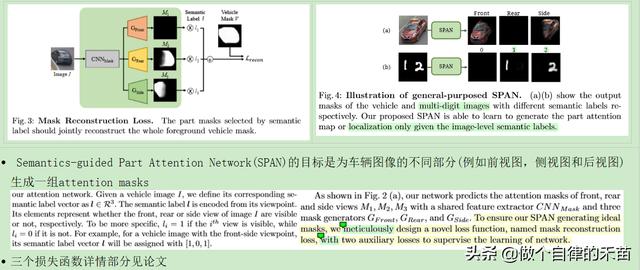

Abstract дҪңиҖ…жҸҗеҮәдәҶдёҖдёӘSemantic-guided Part Attention NetworkпјҲSPANпјү пјҢ иҜҘзҪ‘з»ңеңЁи®ӯз»ғйҳ¶ж®өеңЁд»…д»…з»ҷеҮәimage-levelзҡ„иҜӯд№үж ҮзӯҫдёӢ пјҢ еҸҜд»ҘиҪҰиҫҶдёҚеҗҢи§Ҷи§’дёӢзҡ„part attention masks пјҢ еңЁpart attention masksзҡ„её®еҠ©дёӢ пјҢ еҸҜд»ҘеҲҶеҲ«жҸҗеҸ–еҮәжҜҸдёӘpartзҡ„жңүеҢәеҲ«еҠӣзҡ„зү№еҫҒ пјҢ 然еҗҺеј•е…ҘдәҶCo-occurrence Part-attentive Distance Metric (CPDM)пјҢ иҜҘеәҰйҮҸж ҮеҮҶеңЁиҜ„дј°дёӨдёӘеӣҫеғҸзҡ„зү№еҫҒи·қзҰ»ж—¶жӣҙеҠ йҮҚи§Ҷе…ұзҺ°зҡ„иҪҰиҫҶйғЁеҲҶ гҖӮ

Introduction

- йҰ–е…Ҳеј•е…ҘSemantics-guided Part Attention NetworkпјҲSPANпјүз”ҹжҲҗиҪҰиҫҶдёҚеҗҢйғЁдҪҚпјҲfrontгҖҒside and rear viewsпјүзҡ„attention masks гҖӮ The masksдёҚд»…жңүеҠ©дәҺеҲҶжё…дёҚеҗҢи§Ҷи§’зҡ„зү№еҫҒ пјҢ иҖҢдё”иҝҳеҸҜд»Ҙж”№е–„жҲ‘们еӯҰд№ жЎҶжһ¶зҡ„еҸҜи§ЈйҮҠжҖ§ гҖӮ еҖјеҫ—жіЁж„Ҹзҡ„жҳҜ пјҢ SPANдёҚйңҖиҰҒжҳӮиҙөзҡ„е…ій”®зӮ№жҲ–еғҸзҙ зә§ж ҮзӯҫиҝӣиЎҢи®ӯз»ғ пјҢ иҖҢеҸӘйңҖиҰҒеӣҫеғҸзә§и§Ҷи§’ж ҮзӯҫеҚіеҸҜ(image-level viewpoint labels) пјҢ иҖҢиҝҷдәӣж Үзӯҫжӣҙе®№жҳ“д»Һе·ІзҹҘзҡ„зӣёжңәе§ҝжҖҒе’ҢдәӨйҖҡж–№еҗ‘(traffic direction)еҫ—еҮә гҖӮ

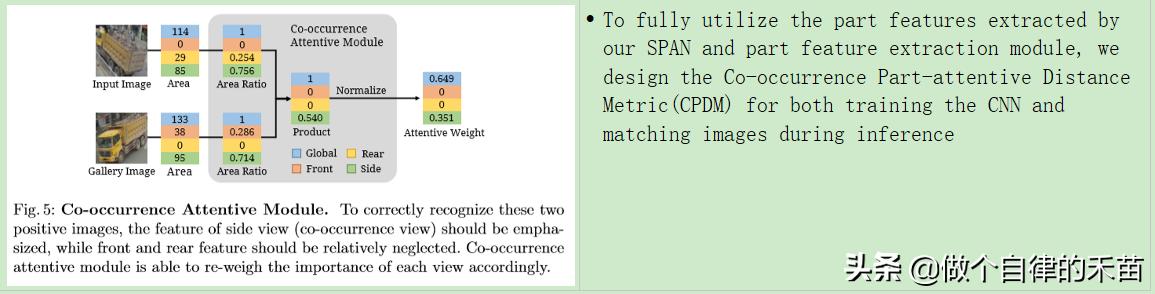

- еҪ“жөӢйҮҸеӣҫеғҸй—ҙи·қзҰ»ж—¶ пјҢ еј•е…ҘCo-occurrence Part-attentive Distance Metric(CPDM)д»ҘжӣҙеҘҪең°еҲ©з”Ёthe part features пјҢ жҸҗеҮәзҡ„еәҰйҮҸж ҮеҮҶдҪҝжҲ‘们иғҪеӨҹж №жҚ®дёӨдёӘжҜ”иҫғзҡ„иҪҰиҫҶеӣҫеғҸдёӯзҡ„the part visibilityиҮӘеҠЁи°ғж•ҙжҜҸдёӘpart feature distanceзҡ„йҮҚиҰҒжҖ§ гҖӮ (зӣҙзҷҪиҜҙе°ұжҳҜдёӨдёӘеӣҫеғҸдёӯеҸҜи§Ғpartзҡ„зӣёдјјзЁӢеәҰи¶Ҡй«ҳ пјҢ иҝҷдёӨеј еӣҫзүҮеұһдәҺдёҖдёӘIDзҡ„иҪҰзҡ„еҸҜиғҪжҖ§е°ұи¶Ҡй«ҳ)

- жҖ»з»“е°ұжҳҜ пјҢ SPANз”ҹжҲҗзҡ„the attention masksжҸҗеҸ–жңүз”Ёзҡ„part features пјҢ CPDMеҸҜд»ҘжӣҙеҘҪең°еҲ©з”Ёthe global and part featuresжқҘж”№е–„re-IDжҖ§иғҪ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ- Semantics-guided Part Attention Network

ж–Үз« жҸ’еӣҫ

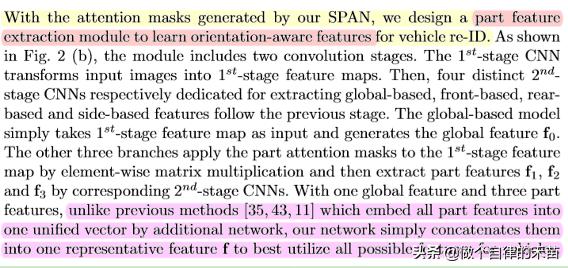

ж–Үз« жҸ’еӣҫ- Part Feature Extraction

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ- Co-occurrence Part-attentive Distance Metric

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫйҷӨдәҶglobal featureеӨ– пјҢ дёҚеҗҢиҪҰиҫҶдёҠзӣёеҗҢеҸҜи§Ғpartзҡ„зү№еҫҒеҜ№дәҺre-IDд№ҹиҮіе…ійҮҚиҰҒ пјҢ жӯӨеӨ– пјҢ е…·жңүиҫғеӨ§йқўз§ҜжҜ”зҡ„е…ұзҺ°йғЁеҲҶйҖҡеёёиЎЁзӨәжӣҙй«ҳзҡ„жё…жҷ°еәҰ пјҢ жҲ–иҖ…еңЁеҸҜиғҪеҢ…жӢ¬еҺҹе§ӢеӣҫеғҸдёӯжӣҙеӨҡзҡ„е…ій”®зү№еҫҒ пјҢ еӣ жӯӨжҸҗеҮәдәҶCo-occurrence Attentive Module пјҢ д»ҘйҖҡиҝҮCPDMз»јеҗҲиҖғиҷ‘дёӨдёӘеӣҫеғҸдёӯжҜҸдёӘи§Ҷеӣҫзҡ„йқўз§ҜжҜ”жқҘйҮҚж–°иЎЎйҮҸдёҚеҗҢзү№еҫҒи·қзҰ»зҡ„йҮҚиҰҒжҖ§пјҲзҷҪиҜқе°ұжҳҜе…¬ејҸ5жүҖзӨә пјҢ дҪҝз”ЁCPDM пјҢ еҸҜд»Ҙдёә4дёӘзү№еҫҒи·қзҰ»еҲҶй…ҚдёҚдёҖж ·зҡ„жқғйҮҚ пјҢ 4дёӘзү№еҫҒи·қзҰ» = 1дёӘе…ЁеұҖзү№еҫҒи·қзҰ»+3дёӘpartsзҡ„зү№еҫҒи·қзҰ»пјү