Nvidia研究人员设计出用较少数据训练GAN的方法

Nvidia的研究人员创造了一种用于训练生成式对抗网络(GANs)的增强方法 , 这种方法需要的数据较少 。 Nvidia已经制作了GAN用于创作风景画等艺术作品的案例 , 最近又制作了一个用于视频会议的GAN 。 GAN是人工智能的一种形式 , 它将一个生成器网络与一个判别器网络对立起来 , 以创建图像或视频) 。

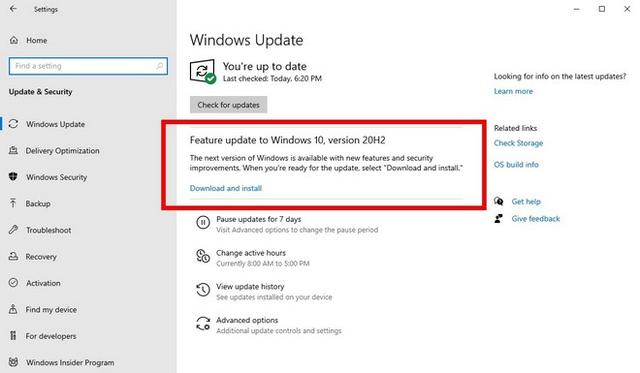

文章插图

文章插图

一般而言 , 训练GAN可能需要多达10万张以上的图像 , 但在 "用有限数据训练生成式对抗网络 "一文中详述的一种称为自适应判别器增强(ADA)的方法 , 可以用少10到20倍的数据实现结果 。

"小数据集的关键问题是 , 判别器对训练实例的过度拟合;其对生成器的反馈变得毫无意义 , 训练开始出现分歧 , "论文写道 。 "我们在几个数据集上证明 , 现在只需使用几千张图片就可以获得良好的结果 , 通常用少一个数量级的图片就可以匹配StyleGAN2的结果 。 "

今年早些时候 , 来自Adobe Research、MIT和清华大学的研究人员共同详细介绍了DiffAugment , 这是GANs的另一种增强方法 。

Nvidia图形研究副总裁David Luebke表示 , 任何做过实用数据科学的人都知道 , 绝大部分时间都花在收集和策划数据上 。 这有时被称为ETL管道:提取、转换和加载 。 他说 , 当与时间不多的注释者合作时 , 这一点可能更加重要 。

论文作者认为 , 减少数据限制可以使研究人员有能力检查GANs的新用例 。 除了创建人或动物的假照片之外 , 研究人员认为GANs可能会在医学成像数据中得到应用 。

"如果你有一位专攻某种特定病症的放射科医生......让他或她坐下来为你标注5万张图像这种事情大概率不会发生......但让他们标注1000张图像似乎很有可能 。 Luebke说:"这确实改变了一个实用的数据科学家需要投入到数据策展中的工作量 , 因此 , 它使得做探索变得更加容易 。 " 。

【Nvidia研究人员设计出用较少数据训练GAN的方法】本周发表的一篇详细介绍该方法的论文 , 作为神经信息处理网络NeurIPS会议的一部分 , 这是世界上最大的年度人工智能研究会议 。

"用有限的数据训练生成式对抗网络 "并不是唯一的GAN相关论文 。 另一篇研究论文介绍了Discriminator Driven Latent Sampling(DDLS) , 在使用CIFAR-10数据集进行评估时 , 该方法实现了现成GAN的性能改进 。 该论文由MILA魁北克人工智能研究所和谷歌大脑研究人员撰写 , 其中包括Yoshua Bengio和蒙特利尔谷歌大脑小组负责人、NeurIPS会议总主席Hugo Larochelle 。

推荐阅读

- 金士顿发布Workflow Station - 为内容创作者设计的模块化底座

- iQOO 7官方美图赏:三种配色、速度美学设计传承

- NVIDIA 461.09版显卡驱动发布:修复GTX 750 Ti蓝屏死机

- 新款iPad mini或于3月亮相,小米11 Pro摄像模组设计曝光

- vivo追求的本原设计是什么?X60 Pro给出了答案

- realme真我V15国潮锦鲤手机发布《国家宝藏》联名设计

- 传世名画《洛神赋图》赋予设计灵感!realme V15上架预约

- 苹果M1、A14内核设计对比:差别很大

- 外媒赞赏戴尔笔记本的摄像头隐私挡板设计 希望其它厂商能够跟进

- 研究人员吐槽当前AI训练效率过于低下