еӯӨжғҜ|еҫ®иҪҜ Bing жҗңзҙўж ёеҝғжҠҖжңҜ BitFunnel еҺҹзҗҶжҸӯз§ҳ( дәҢ )

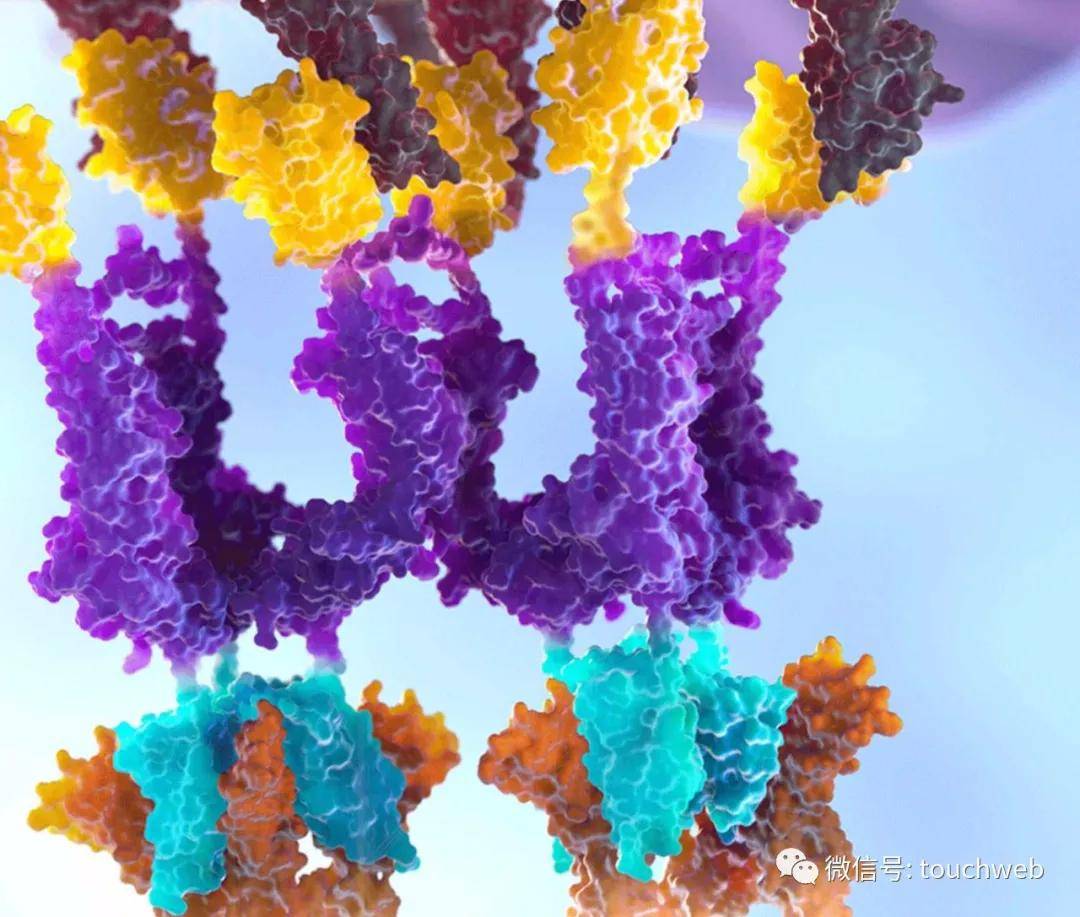

иҝҷж ·зҡ„д»Јд»·ж— з–‘жҳҜйқһеёёй«ҳжҳӮзҡ„ пјҢ еӣ дёәзҺ°еңЁж–Үз« зҡ„ж•°йҮҸе’Ңй•ҝеәҰд№ҳз§Ҝж— з–‘жҳҜдёҖдёӘеӨ©ж–Үж•°еӯ— гҖӮ дёҖдёӘйқһеёёе·§еҰҷзҡ„еҠһжі•е°ұжҳҜе°ҶиҝҷдёӘзҹ©йҳөеҸҚиҪ¬иҝҮжқҘ пјҢ иЎҢеҲ—еҖ’зҪ® пјҢ йӮЈд№ҲжҲ‘们зҡ„еӯҳеӮЁз”ұNпјҠPиЎҢеҲ—зҹ©йҳөе°ұеҸҳжҲҗдәҶPпјҠN пјҢ еҫҲжҳҫ然 пјҢ Pиҝңиҝңе°ҸдәҺN гҖӮ йӮЈд№Ҳ пјҢ жҲ‘们зҡ„жҹҘиҜўж–ҮжЎЈQueryеҜ№еә”зҡ„еҸӘйңҖиҰҒеҺ»еҢ№й…Қе…¶дёӯдҪҚдёә1зҡ„еҜ№еә”зҡ„ж–ҮжЎЈзҡ„иЎҢеҗ‘йҮҸеҚіеҸҜ пјҢ иҝҮзЁӢеҰӮдёӢпјҡ

д»ҺдёҠеӣҫжөҒзЁӢеҸҜд»ҘзңӢеҮә пјҢ еҜ№еә”зҡ„еҸӘйңҖиҰҒжҹҘиҜўеҜ№еә”дёә1зҡ„дҪҚеҗ‘йҮҸиЎҢж•°зҡ„ж–Үз« зҡ„жғ…еҶөе°ұеҸҜд»ҘдәҶ пјҢ еҒҮи®ҫзңҹе®һдёӯжҹҘиҜўзҡ„ж–ҮжЎЈQueryзҡ„дёә1дҪҚж•°жҳҜWдҪҚ пјҢ еңЁзҺ°е®һжҹҘиҜўдёӯ пјҢ WеҫҖеҫҖжҳҜе°‘ж•°еҮ дёӘеҚ•иҜҚеҺ»жҹҘиҜў пјҢ Wиҝңиҝңе°ҸдәҺP пјҢ еҜ№еә”еҲ—иҝӣиЎҢ并иҝҗз®— пјҢ з»“жһңдёә1еҲҷиҜҘзҜҮдҪҚзҪ®еҸҜиғҪеҢ№й…Қ пјҢ иҝҷж ·жҹҘиҜўйҖҹеәҰе°ұеӨ§еӨ§жҸҗеҚҮ гҖӮ дҪҶжҳҜ пјҢ иҝҳжңүдёҖдёӘй—®йўҳе°ұжҳҜзҺ°е®һдёӯ N зҡ„ж•°йҮҸд№ҹйқһеёёеәһеӨ§ гҖӮ

йӮЈд№ҲиҝҷзӮ№еҰӮдҪ•еӨ„зҗҶе‘ўпјҹиҝҷе°ұеј•иҝӣдәҶд»ҠеӨ©иҰҒи®Ізҡ„йҮҚзӮ№з®—жі•пјҡBitFunnel гҖӮ

BitFunnelеҸ‘жҳҺзӯүзә§иЎҢ

зӯүзә§иЎҢжҳҜеҺҹе§ӢиЎҢзҡ„з®ҖеҚ•еҺӢзј©зүҲжң¬ пјҢ иғҪеӨҹжҸҗй«ҳиҝҮж»ӨйҖҹеәҰ пјҢ дҪҶеҗҢж—¶д№ҹеёҰжқҘдәҶжӣҙй«ҳзҡ„й”ҷиҜҜзҺҮ пјҢ и®©жҲ‘们зңӢзңӢзӯүзә§иЎҢжҳҜжҖҺд№ҲиҝҗиЎҢзҡ„ гҖӮ жҲ‘们е°ҶеҺҹе§ӢиЎҢз§°дёә0-зӯүзә§иЎҢ пјҢ еҒҮи®ҫеҺҹе§ӢиЎҢжҳҜ32дҪҚй•ҝеәҰ пјҢ йӮЈд№Ҳ1-зӯүзә§иЎҢе°ұжҳҜз”ұ0пјҚзӯүзә§иЎҢеҜ№зӯүжҲӘжҲҗдёӨеҚҠиҝӣиЎҢжҲ–иҝҗз®—иҺ·еҫ— пјҢ йӮЈд№Ҳй•ҝеәҰе°ұйҷҚдҪҺдәҶдёҖеҚҠ пјҢ жӣҙй«ҳзӯүзә§иЎҢдҫқжӯӨиҝӣиЎҢи®Ўз®—иҺ·еҫ— пјҢ еҰӮдёӢеӣҫдёҫдҫӢжүҖзӨәпјҡ

йӮЈд№ҲзҺ°еңЁжҲ‘们жҖҺд№ҲдҪҝз”ЁжҲ‘们иҺ·еҸ–зҡ„зӯүзә§иЎҢе‘ўпјҹеҒҮи®ҫжҲ‘们жңү3иЎҢ32еҲ—йңҖиҰҒеҢ№й…ҚеӨ„зҗҶ пјҢ йӮЈд№ҲжҲ‘们еҸҜд»ҘиҖғиҷ‘е°Ҷ第дёҖиЎҢеҺӢзј©жҲҗ2пјҚзӯүзә§иЎҢ пјҢ 第дәҢиЎҢеҺӢзј©жҲҗ1пјҚзӯүзә§иЎҢ пјҢ 第дёүиЎҢдҝқжҢҒдёҚеҸҳ гҖӮ еҰӮжһңжҲ‘们没жңүиҝҷж ·еҒҡ пјҢ жҲ‘们йңҖиҰҒе°Ҷ3*32пјқ96дҪҚе…ЁйғЁж”ҫиҝӣеҶ…еӯҳиҝӣиЎҢжҹҘиҜўеӨ„зҗҶжүҚеҸҜд»Ҙе®ҢжҲҗ гҖӮ иҖҢзҺ°еңЁ пјҢ пјҲ8+16+32пјүпјқ56дҪҚ пјҢ иҜҰз»ҶеҰӮдёӢеӣҫжүҖзӨәпјҡ

йӮЈд№ҲжҹҘиҜўзҡ„ж—¶еҖҷ пјҢ жҲ‘们е…Ҳе°Ҷеҫ—еҮә第дёҖиЎҢе’Ң第дәҢиЎҢзҡ„并иҝҗз®—з»“жһң пјҢ д»…дёӨеҲ—йңҖиҰҒеҺ»дёҺ第дёүиЎҢеңЁиҝӣиЎҢеӨ„зҗҶ пјҢ 然еҗҺ平移еҲ°з¬¬дёүиЎҢеҸҰдёҖиҫ№еӨ„зҗҶ пјҢ еҶҚе°Ҷ第дёҖиЎҢ移еҠЁеҲ°з¬¬дәҢиЎҢзҡ„еҸҰеӨ–дёҖиҫ№ пјҢ иҝҷж—¶еҖҷд№ҹжҳҜдёӨеҲ—еқҮдёә1еҮәзҺ° пјҢ 然еҗҺдёҺ第дёүиЎҢеӨ„зҗҶ пјҢ еҶҚиҪ¬з§»еӣһеҺ»еӨ„зҗҶжңҖеҗҺдёҖж¬ЎеҚіеҸҜеҫ—еҮәз»“жһң пјҢ еӣӣж¬ЎеӨ„зҗҶи®Ўз®—жөҒзЁӢеҰӮдёӢпјҡ

д»ҘдёҠиҝҷж ·зҡ„еӨ„зҗҶжҲ‘们еҸҜд»ҘеӨ§йҮҸең°еҲ©з”Ёдёӯй—ҙз»“жһңеҠ еҝ«и®Ўз®— гҖӮ

йў‘зҺҮеёғйҡҶиҝҮж»ӨеҷЁ

дј з»ҹзҡ„еёғйҡҶиҝҮж»ӨеҷЁйңҖиҰҒиҠұиҙ№и¶…й•ҝеәҰзҡ„дҪҚеҗ‘йҮҸжүҚиғҪеҒҡеҲ°ж»Ўи¶іиҫғдҪҺзҡ„й”ҷиҜҜзҺҮ пјҢ иҖҢBitFunnelеҲҷдҪҝз”Ёйў‘зҺҮеёғйҡҶиҝҮж»ӨеҷЁжқҘйҷҚдҪҺеҶ…еӯҳжҖ»йҮҸ гҖӮ д»Җд№ҲжҳҜйў‘зҺҮеёғйҡҶиҝҮж»ӨеҷЁпјҹеҪ“жҲ‘们еңЁеёғйҡҶиҝҮж»ӨеҷЁдёӯжҹҘиҜўд»…д»…жҹҘиҜўдёҖдёӘйЎ№зӣ®ж—¶ пјҢ еҒҮи®ҫж•ҙдёӘеёғйҡҶиҝҮж»ӨеҷЁдёә1зҡ„еҜҶеәҰдёә10% пјҢ йӮЈд№ҲеҪ“жҲ‘们еҸӘдҪҝз”ЁдёҖдёӘе“ҲзЁҖеҮҪж•°пјҲеҒҮи®ҫе“ҲзЁҖеҮҪж•°жҳҜе®Ңе…ЁйҡҸжңәе“ҲзЁҖеҮҪж•°пјү пјҢ йӮЈд№ҲеҜ№еә”зҡ„зў°ж’һзҺҮдёә10пј… пјҢ йӮЈд№ҲйҡҸзқҖжҲ‘们е“ҲзЁҖеҮҪж•°з§Қзұ»зҡ„еўһеҠ пјҢ жҲ‘们еҸҜд»Ҙи®Ўз®—еҮәй”ҷиҜҜзҺҮ,dдёәеёғйҡҶиҝҮж»ӨеҷЁзҡ„жҰӮзҺҮеҜҶеәҰ пјҢ дҪҶиҝҷйҮҢжҲ‘们еҸҜд»ҘиҝӣдёҖжӯҘжҸҗеҮәж–°зҡ„жҰӮеҝөдҝЎеҷӘжҜ”пјҡ

жҺЁиҚҗйҳ…иҜ»

- еҝҳе·қеҪјеІё|еҗҜиҝӘи®ҫи®Ўдёӯж Үеҫ®иҪҜпјҲдёӯеӣҪпјүиӢҸе·һ科жҠҖеӣӯеҢәдәҢжңҹеҠһе…¬жҘјйЎ№зӣ®и®ҫи®ЎжҖ»еҢ…

- еӯӨжғҜ|жҖ§д»·жҜ”жңҖй«ҳзҡ„з”өи„‘йҹіз®ұжңүе“Әдәӣпјҹ20ж¬ҫ50-500е…ғз”өи„‘йҹіз®ұжҺЁиҚҗ

- жёёжҲҸжңә|жңҖдҪіжёёжҲҸе№іеҸ°иҜ„йҖүпјҒд»»еӨ©е ӮгҖҒзҙўе°је’Ңеҫ®иҪҜе…ЁйғҪиҙҘз»ҷдәҶPCз”өи„‘

- еҫ®иҪҜ|зЎ¬зӣҳж»ЎдәҶеҲ«еҸ‘ж„ҒпјҢWindows 10е°Ҹе·Ҙе…·её®дҪ иҪ»жқҫйҮҠж”ҫеӯҳеӮЁз©әй—ҙ

- иҪ»жӢ”зҗҙејҰ|йқһеёёејәеӨ§пјҢзЎ¬ж ёпјҒеҫ®иҪҜдә‘K8SеӯҰд№ жҢҮеҚ—е…Қиҙ№йўҶеҸ–дәҶ

- йӮЈе№ҙеҲқеӨҸ|дёҖжӣҙж–°е°ұеҮәдәӢзҡ„win10пјҒSSDзЎ¬зӣҳиў«еқ‘еҜҝе‘ҪеҸ—жҚҹпјҢеҫ®иҪҜе·ІжӯЈи§Ҷ

- иҘҝзәўжҹҝе°Ҹз”ҹ|еҲ°еә•еҖјдёҚеҖјпјҹеҫ®иҪҜиҪ»и–„и¶…жһҒжң¬ж”ҫеҲ°зҺ°еңЁпјҢиҝҳжңүеҗёеј•еҠӣеҗ—пјҹ

- |5еҲҶй’ҹиҜ»жҮӮеҫ®иҪҜж–°жҠҖжңҜпјҡжңӘжқҘжёёжҲҸеҰӮдҪ•ж¶ҲзҒӯиҜ»жқЎ

- еӯӨжғҜ|йҖҡз”Ёдәәе·ҘжҷәиғҪе•Ҙж—¶еҖҷиғҪе®һзҺ°пјҹиҝҷжҳҜжҲ‘зҡ„жңҖж–°йў„жөӢ

- йҹӯиҸңиҠұйҹід№җ|зҝ»ж–°жңә6.4жҠҳиө·пјҢеҫ®иҪҜе•ҶеҹҺеҗҜеҠЁејҖеӯҰеӯЈжҙ»еҠЁпјҡSurfaceзӯүж–°е“Ғдә«9жҠҳ