图神经网络越深,表现就一定越好吗?

本文插图

编译 | 陈彩娴

编辑 | 丛 末

数十层甚至数百层神经网络的应用 , 是深度学习的重要标志之一 。 但现实情况却远非如此:比如今年被视作机器学习领域最火热的研究方向之一——图神经网络 , 大多数都只运用了寥寥几层网络 。

一般思路里 , 我们会认为图神经网络越深 , 效果就会越好 。 然而 , 日前帝国理工学院教授Michael Bronstein 发出了灵魂拷问:图神经网络的深度 , 真的会带来优势吗?

本文插图

“深度图神经网络”是否被误用了?或者说 , 我们是否应该重新审视以前认为“图神经网络越深 , 效果就会越好”的思路 , 说不定“深度”反而对基于图的深度学习不利呢?

众所周知 , 深度图神经网络的训练过程非常艰难 。 除了研究者们能够在深层神经体系结构中观察到的典型难点外(比如大量参数导致反向传播梯度消失和过度拟合) , 还有一些图特有的难点 , 例如“过度平滑”:由于应用了多个图卷积层 , 节点特征趋于收敛到同一向量并逐渐变得难以区分 。 这个现象最早在GCN模型中观察到 , 其作用类似于低通滤波器 。 另一个图所特有的现象是“信息瓶颈” , 会将信息从指数级数量的临域“过度挤压”到大小固定的向量中 。

近日来 , 人们致力于解决图神经网络中的深度问题 , 希望图神经网络能有更好的表现 , 至少能避免“名义上是深度学习、实际上图神经网络却只应用了两层”的尴尬 。

解决之道分为两派:第一类是正则化技术(regularisation techniques) , 例如 DropEdge 方法 , 结点特征之间的成对距离归一化(PairNorm)或结点均值和方差归一化(NodeNorm);第二类是架构调整 , 包括各类残差连接 , 例如知识跳跃或仿射残差连接 。

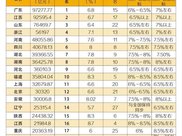

虽然这些方法可以训练出具有数十层深度图神经网络(这是一项壮举 , 并非不可能实现) , 但却没有产生令人满意的效果 。 更糟糕的是 , 使用深度结构体系通常会导致性能的倒退 。 下表显示了一个典型的实验评估结果 , 比较了node-wise分类任务上不同深度的图神经网络的表现 。

本文插图

此表显示了深度图神经网络架构在CoauthorsCS引文网络的结点分类任务上的一般结果 。 深度越深 , 基线(带有残差连接的GCN)的表现越差 , 性能也从88.18%急剧下降至39.71% 。 使用NodeNorm技术的神经网络架构随着深度的增加会变得更好 ,但是性能却开始下降(虽然仅是从89.53%降低到87.40%) 。 总体而言 , 64层深层架构获得的最佳结果(87.40%)还不如简单的基线(88.18%) 。 此外 , 我们注意到NodeNorm规则化可以改善浅层2层架构的性能(从88.18%增至89.53%) 。 上表源自论文《 Effective training strategies for deep graph neural networks》

从上表可以清晰看到 , 我们很难区分神经网络的“优势”是从深度网络架构获得的 , 还是从训练此类神经网络的“技巧”所获得的 。 上述示例中的NodeNorm还改进了仅有两层的浅层架构 , 从而实现了最佳性能 。 因此 , 我们无法确定在其他条件均相同的情况下 , 更深层数的图神经网络是否会表现得更好 。

这些结果与基于网格结构数据的传统深度学习形成了鲜明的对比 。 在传统深度学习中 , “超深度”架构能带来性能上的突破 , 在当今也得到了广泛应用 。

接下来 , 作者尝试从以下几个方面来探索文章开头所提出的问题:图神经网络的深度越深 , 真的优势越大吗?不过作者也表示 , 他目前也没有一个明确的答案 , 希望下面这些探讨能够对大家的思考有所启发 。

推荐阅读

- 「韩信」真正的强者,都有这2种“城府”,城府越深,越有福气

- XiaoHu|「群访」 Gala:我今天的表现就是跟着混吧

- 盘车|两分钟解答问题:轮胎的胎纹是越深越好吗?

- 镜中月|沉香手链为什么越戴颜色越深?

- #男友#男生是否“真的爱你”,从这3种表现就可看出来,全中就嫁了吧

- 科技匠|为什么我们的神经网络需要激活函数

- 科技怪人|我们真的需要深度图神经网络吗?

- Array|我们真的需要深度图神经网络吗?

- AI人工智能我们真的需要深度图神经网络吗?

- 葡萄|颜色越深越好!不知道这三点就白吃了水果中的溶栓之王