зӣ‘жҺ§|еӨӘиөһдәҶпјҒеӨ§дҪ¬з«ҹ然用ELKжҗӯе»әиө·дәҶж”Ҝж’‘TBзә§зҡ„ж—Ҙеҝ—зӣ‘жҺ§зі»з»ҹ( дәҢ )

жҠҖжңҜжҲ‘们йҮҮз”Ё Kafka Streams дҪңдёә ETL жөҒеӨ„зҗҶгҖӮйҖҡиҝҮз•ҢйқўеҢ–й…ҚзҪ®е®һзҺ°еҠЁжҖҒиҝҮж»Өжё…жҙ—зҡ„规еҲҷгҖӮ

еӨ§жҰӮ规еҲҷеҰӮдёӢпјҡ

з•ҢйқўеҢ–й…ҚзҪ®ж—Ҙеҝ—йҮҮйӣҶгҖӮй»ҳи®Ө Error зә§еҲ«зҡ„ж—Ҙеҝ—е…ЁйҮҸйҮҮйӣҶгҖӮ

д»Ҙй”ҷиҜҜж—¶й—ҙзӮ№дёәдёӯеҝғпјҢеңЁжөҒеӨ„зҗҶдёӯејҖзӘ—пјҢиҫҗе°„дёҠдёӢеҸҜй…Қзҡ„ N ж—¶й—ҙзӮ№йҮҮйӣҶйқһ Error зә§еҲ«ж—Ҙеҝ—пјҢй»ҳи®ӨеҸӘйҮҮ info зә§еҲ«гҖӮ

жҜҸдёӘжңҚеҠЎеҸҜй…Қ 100 дёӘе…ій”®ж—Ҙеҝ—пјҢй»ҳи®Өе…ій”®ж—Ҙеҝ—е…ЁйҮҸйҮҮйӣҶгҖӮ

еңЁж…ў SQL зҡ„еҹәзЎҖдёҠпјҢжҢүдёҡеҠЎеҲҶзұ»й…ҚзҪ®дёҚеҗҢзҡ„иҖ—ж—¶еҶҚж¬ЎиҝҮж»ӨгҖӮ

жҢүдёҡеҠЎйңҖжұӮе®һж—¶з»ҹи®ЎдёҡеҠЎ SQLпјҢжҜ”еҰӮпјҡй«ҳеі°жңҹйҳ¶ж®өпјҢз»ҹи®ЎдёҖе°Ҹж—¶еҶ…еҗҢзұ»дёҡеҠЎ SQL зҡ„жҹҘиҜўйў‘зҺҮгҖӮеҸҜдёә DBA жҸҗдҫӣдјҳеҢ–ж•°жҚ®еә“зҡ„дҫқжҚ®пјҢеҰӮжҢүжҹҘиҜўзҡ„ SQL еҲӣе»әзҙўеј•гҖӮ

й«ҳеі°ж—¶ж®өжҢүдёҡеҠЎзұ»еһӢзҡ„жқғйҮҚжҢҮж ҮгҖҒж—Ҙеҝ—зӯүзә§жҢҮж ҮгҖҒжҜҸдёӘжңҚеҠЎеңЁдёҖдёӘж—¶ж®өеҶ…ж—Ҙеҝ—жңҖеӨ§йҷҗеҲ¶йҮҸжҢҮж ҮгҖҒж—¶й—ҙж®өжҢҮж ҮзӯүеҠЁжҖҒжё…жҙ—иҝҮж»Өж—Ҙеҝ—гҖӮ

ж №жҚ®дёҚеҗҢзҡ„ж—¶й—ҙж®өеҠЁжҖҒ收缩时й—ҙзӘ—еҸЈгҖӮ

ж—Ҙеҝ—зҙўеј•з”ҹжҲҗ规еҲҷпјҡжҢүжңҚеҠЎз”ҹжҲҗзҡ„ж—Ҙеҝ—ж–Ү件规еҲҷз”ҹжҲҗеҜ№еә”зҡ„ indexпјҢжҜ”еҰӮпјҡжҹҗдёӘжңҚеҠЎж—Ҙеҝ—еҲҶдёәпјҡdebugгҖҒinfoгҖҒerrorгҖҒxx_keywordпјҢйӮЈд№Ҳз”ҹжҲҗзҡ„зҙўеј•д№ҹжҳҜ debugгҖҒinfoгҖҒerrorгҖҒxx_keyword еҠ ж—ҘжңҹдҪңеҗҺзјҖгҖӮиҝҷж ·еҒҡзҡ„зӣ®зҡ„жҳҜдёәз ”еҸ‘д»ҘеҺҹд№ жғҜжҖ§ең°еҺ»дҪҝз”Ёж—Ҙеҝ—гҖӮ

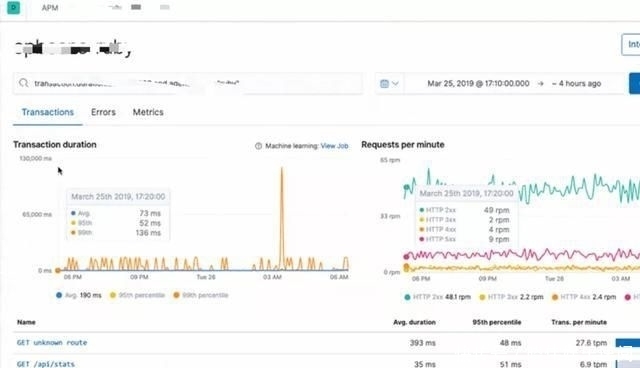

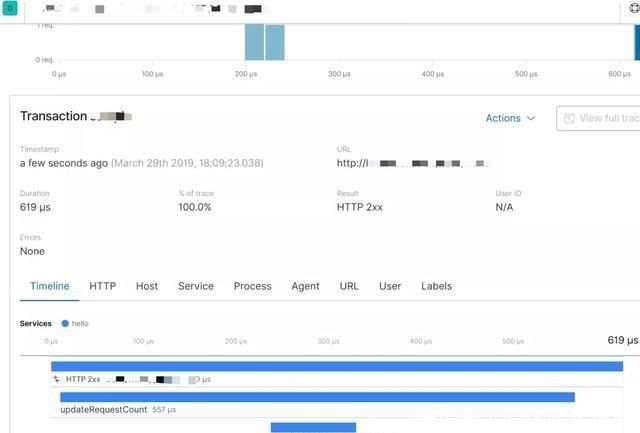

в‘ҰеҸҜи§ҶеҢ–з•ҢйқўжҲ‘们主иҰҒдҪҝз”Ё GrafanaпјҢе®ғж”ҜжҢҒзҡ„дј—еӨҡж•°жҚ®жәҗдёӯпјҢе…¶дёӯе°ұжңүжҷ®зҪ—зұідҝ®ж–Ҝе’Ң ElasticsearchпјҢдёҺжҷ®зҪ—зұідҝ®ж–ҜеҸҜи°“жҳҜж— зјқеҜ№жҺҘгҖӮиҖҢ Kibana жҲ‘们主иҰҒз”ЁдәҺ APM зҡ„еҸҜи§ҶеҲҶжһҗгҖӮ

ж—Ҙеҝ—еҸҜи§ҶеҢ–

ж–Үз« еӣҫзүҮ

ж–Үз« еӣҫзүҮ

ж–Үз« еӣҫзүҮ

ж–Үз« еӣҫзүҮ

ж–Үз« еӣҫзүҮ

ж–Үз« еӣҫзүҮ

жҺЁиҚҗйҳ…иҜ»

- ж–°дә¬жҠҘ|жҠҪе№Іж№–ж°ҙи°ғеҸ–зӣ‘жҺ§д»ҚдёҚи§ҒпјҢзҰ»еҘҮеӨұиёӘеҘіеӯҗзҰ»е®¶еүҚеҺ»иҝҮе“ӘпјҹдёЁеҠЁз”»иҝҳеҺҹ

- зһ¬й—ҙ|з”өеҠЁиҪҰиҝқз« зһ¬й—ҙжңүеӨҡжғЁзғҲй©ҫ驶е‘ҳиў«ж’һеҖ’йЈһиө·пјҒзӣ‘жҺ§з”»йқўиҝҳеҺҹзҺ°еңәпјҒ

- е®ўеҺ…иЈ…дҝ®и®ҫи®Ўж•Ҳжһңеӣҫ|е°ҸеӨ«еҰ»жү“йҖ 85е№іеҢ—欧йЈҺпјҢе°ҸеҚ§е®Өж”№дёӘжҖ§д№ҰжҲҝеӨӘиөһдәҶпјҢзңӢе®Ңе°ұжғіеӣһ家改

- зӣ‘жҺ§и§Ҷйў‘|е°ұйӨҗж—¶жҚЎеҲ°йҮ‘жүӢй•ҜпјҢеҪ’иҝҳз»ҷеӨұдё»еҗҺпјҢеҘ№е“ӯдәҶвҖҰвҖҰ

- еҝ—ж„ҝжңҚеҠЎ|18ж—Ҙжұҹй—Ёиҝҷеңәжҙ»еҠЁеӨӘиөһдәҶпјҒ

- жқӯе·һдёҖе№ҙиҪ»е§‘еЁҳжғҠж…Ңи·‘еҮәеҺ•жүҖпјҡвҖңеҝ«пјҒеё®жҲ‘зңӢзӣ‘жҺ§пјҢжңүдәәеҒ·жӢҚпјҒвҖқ

- е°ҸеҢәдҝқе®үзҰ»иҒҢеҗҺпјҢзӘҒеҸ‘еҫ®дҝЎе‘ҠиҜүдёҡдё»пјҡдҪ иў«зӣ‘жҺ§й•ҝиҫҫдёҖе№ҙд№Ӣд№…пјҒзңҹзӣёз»ҶжҖқжһҒжҒҗ

- жөҷж ·зҡ„з”ҹжҙ»|дҪ е·Іиў«зӣ‘жҺ§дёҖе№ҙпјҒзҰ»иҒҢе°ҸеҢәдҝқе®үзӘҒ然еҸ‘еҫ®дҝЎе‘ҠиҜүдёҡдё»пјҢзңҹзӣёз»ҶжҖқжһҒжҒҗ

- е°ҸеҢәдҝқе®үзҰ»иҒҢеҗҺ, зӘҒ然еҸ‘еҫ®дҝЎе‘ҠиҜүдёҡдё»:дҪ иў«зӣ‘жҺ§й•ҝиҫҫдёҖе№ҙд№Ӣд№…!

- ж•ҙе®№жүӢжңҜ|д»–жӣҫжҳҜжңҖзҫҺеҘіиЈ…еӨ§дҪ¬пјҢиө°дёҠж•ҙе®№д№Ӣи·ҜпјҢзҪ‘еҸӢпјҡи¶ҠжқҘи¶ҠеғҸжҪҳеҚ—еҘҺпјҒ

![[з–ҫз—…ж—©йў„йҳІ]иҝҷж ·вҖңдёүжӯҘиө°вҖқжүҚжҳҜж…ўд№ҷиӮқзҡ„жІ»з–—зӣ®ж Ү](http://ttbs.guangsuss.com/image/3bc8818b8fb320c427d4a227673c8419)