新智元|MIT发出“算力”警告:深度学习正在逼近计算极限( 二 )

在去年6月的另一份报告中 , 马萨诸塞大学阿姆赫斯特分校(University of Massachusetts at Amherst)的研究人员得出结论称 , 训练和搜索某一模型所需的能量大约排放了62.6万磅二氧化碳 。 这相当于美国汽车平均寿命的五倍 。

研究人员写道:「我们不认为这些目标所隐含的计算要求……硬件、环境和货币成本会令人望而却步 。 以经济的方式实现这一目标 , 将需要更高效的硬件、更高效的算法或其他改进 , 从而产生如此巨大的净影响 。 」

研究人员指出 , 在算法级别进行深度学习改进已有历史先例 。 他们指出了诸如Google的张量处理单元 , 现场可编程门阵列(FPGA)和专用集成电路(ASIC)之类的硬件加速器的出现 , 以及通过网络压缩和加速技术来降低计算复杂性的尝试 。

他们还引用了神经体系结构搜索和元学习 , 以此使用优化来查找在一类问题上保持良好性能的体系结构 , 以此作为计算上有效的改进方法的途径 。

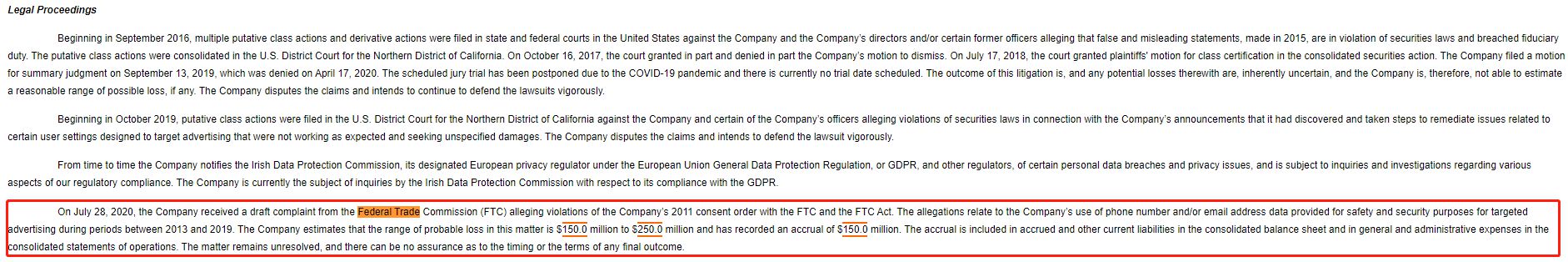

本文插图

算力确实在提高 。 一项OpenAI研究表明 , 自2012年以来 , 每16个月将AI模型训练到ImageNet图像分类中相同性能所需的计算量就减少了2倍 。 Google的Transformer架构超越了以前的状态seq2seq也是由Google开发的模型 , 在seq2seq推出三年后 , 计算量减少了61倍 。

DeepMind的AlphaZero这个系统从零开始教自己如何掌握国际象棋 , 将棋和围棋的游戏 , 而在一年后 , 与该系统的前身AlphaGoZero的改进版本相匹配 , 其计算量就减少了八倍 。

用于深度学习模型的计算能力的爆炸式增长已经结束了「人工智能冬天」 , 并为各种任务的计算机性能树立了新的基准 。

【新智元|MIT发出“算力”警告:深度学习正在逼近计算极限】但是 , 深度学习对计算能力的巨大需求限制了它可以以目前的形式提高性能的程度 , 特别是在硬件性能的提高放缓的时代 。 这些计算限制的可能影响迫使……机器学习转向比深度学习更高效的技术 。

推荐阅读

- 新智元|英国5G建设病急乱投医,这两家日本企业或成华为接盘侠

- 技术编程|Mitch for Twitch Mac版(Twitch客户端工具)v1.8.1

- 新智元|两图生万物!这个超强图像转换神器,小样本一秒猫狗合体变新物种

- 青年|ICML 2020论文贡献榜排名出炉:Google单挑斯坦福、MIT、伯克利;清华进TOP 20

- 检测试剂|新加坡研发出新冠病毒新型检测试剂盒 2小时出结果

- AI人工智能|惨遭下架后,MIT再爆知名数据集ImageNet存在系统性Bug,祸端还是WordNet

- 新智元|TikTok被爆与谷歌云签署8亿美元合同,白宫:卖给美国公司也不行

- 新智元|史无前例被黑,推特有内鬼!

- 科学|曼彻斯特大学研发出石墨烯智能纺织材料,可有效提高服装散热效率

- 科学,电池技术|曼彻斯特大学研发出石墨烯智能纺织材料,可有效提高服装散热效率