科技女王范儿 一文读懂机器学习( 四 )

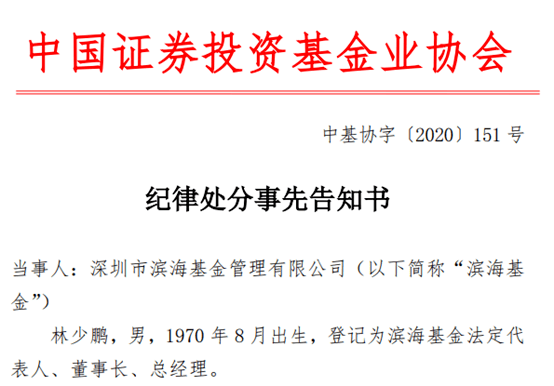

文章图片

就像混淆矩阵一样 , 此图表的对角线上的输入是正确的(预测情况和真实情况一致) , 而副对角线上的输入则是错误的(预测情况和真实情况不一致) 。

于是准确性定义:

文章图片

准确性的问题在于 , 它无法告诉我们结果的所有信息 , 因为它将四个数字变成一个 。 有一些互补的测量值可以帮助我们解释分类器的性能 , 即sensitivity和specificity以及precision和recall 。 接下来显示它们的定义 , 然后进行一些解释 。

文章图片

sensitivity(也称为truepositiverate)是正确的阳性样本与分类为阳性的样本之比 。 specificity是正确的阴性样本与分类为阴性的样本之比 。 precision是正确的阳性样本与实际阳性样本数量的比率 , 预测正确的值中 , 真正预测正确的是对少 , 准确率是多少 。 recall是分类为阳性的阳性样本中正确阳性的样本数量的比率 , 这与sensitivity相同 。 所有正的值中 , 实际找到它多少个 。如果再次查看该图表 , 你会发现sensitivity和specificity的分母是各列的和 , 而precision和recall的分母是第一列和第一行的和 , 因此错过了一些在否定示例中的信息 。

总之 , 这些任何一个都提供了更多的信息 , 而不仅仅是准确性 。 如果你考虑precision和recall , 你会发现它们在某种程度上是负相关的 , 因为如果falsepositive的数量增加 , 那么falsenegative的数量通常会减少 , 反之亦然 。 可以将它们组合在一起以给出一个单独的度量标准 , 即F1度量标准:

文章图片

以及就falsepositive的数量而言

文章图片

基础的数据分析

如果数据是数字类型 , 可以提前做一个数据分析 , 以下几个量是比较常见的:

中位数:数据从小到大排列 , 最中间的数字就是中位数 。 众数:数据中出现次数最多的数字 。 百分位数:如果将一组数据从小到大排序 , 并计算相应的累计百分位 , 则某一百分位所对应数据的值就称为这一百分位的百分位数 。 标准差 , 方差:衡量数据的分布均衡不均衡 。 数据的标准化normalization:以前的数据差距大 , 通过标准化 , 将它们的差距缩小 , 这样使得程序更好的计算 , 数据集和测试集都要标准化 。 异常值outline:异常值的定义方法有很多 , 一种方法是比25%的1.5倍还小或75%的1.5倍(大太多了)还大 , 就是异常值 。 过拟合overfittting和欠拟合underfitting过拟合overfittting:训练数据上效果非常好 , 没见过的数据就不行 。

欠拟合underfitting:训练数据上的效果都不怎么行 。

过拟合发生在相对于训练数据的量和噪声 , 模型过于复杂的情况 。 可能的解决办法有:

简化模型 , 可以通过选择一个参数更少的模型(比如线性模型 , 而不是高阶多项式模型) , 减少训练数据的属性数或限制模型 。 收集更多的训练数据(然而获取额外的训练数据并不是那么轻易和廉价的) 。 减小训练数据的噪声(错误测量引入的教噪声 , 比如修改数据错误 , 去除异常值) 。 限定一个模型让它更简单 , 正则化 。欠拟合发生在你的模型过于简单的时候 , 可能解决的办法有:

选择一个更复杂的模型 , 带有更多的参数 。 用更好的特征训练学习算法(特征工程) 。 减小对模型的限制(比如减小正则化超参数) 。机器学习重点解决的事情如何克服overfitting和underfitting 。 在统计学中 , underfitting和overfittting是biasandvariance 。

biasandvariancebias:随着模型复杂度的上升 , 错误有一些变化 。 模型不够完整 , 没有把相关的特性挖掘出来 。 这种情况叫bias 。

推荐阅读

- 科技一哥|荣耀30青春版图集赏析:触觉与视觉的完美享受

- 绅士老司机|辣妈李亞男身着黑色连体裤外搭休闲西装,满满飒爽范儿

- 科技犬君|vs 索尼A9G 谁强?,上半年用户喜爱手机盘点;小米电视大师65英寸OLED

- 精选泛科技|结果如何?,一加8续航遭质疑:上半年最全机型横评出炉

- 科技犬君上半年用户喜爱手机盘点;小米电视大师65英寸OLED vs 索尼A9G 谁强?

- 科技生活快报TB5000mAh大电池还有65W超级快充!这些手机让你摆脱充电焦虑

- 精选泛科技一加8续航遭质疑:上半年最全机型横评出炉,结果如何?

- 阿拉图图科技说三星新机口碑虽好,但中国市场销量翻车,用户几乎跑光!

- 华为Mate30美科技界:华为再强大也只是一家民企,我们究竟在怕什么?

- 行业|高增长+高回撤!请收好这份“补票”名单,11只核心资产股入围,百亿科技股已跌出“深坑”

![人民网|[网连中国]乡音唱新风、定约除陋习,文明实践最后"一公里"通了](https://mz.eastday.com/18403767.jpg)