InfoQ|研究了 50 篇论文后,他发现 AI 领域的某些进步其实就是炒作

作者 | Matthew Hutson

译者 | 平川

策划 | 陈思

研究人员评估了 81 种剪枝算法、程序 , 它们通过对不需要的连接进行剪枝来提高神经网络的效率 。 这些方法差别不大 , 但所有人都宣称自己具有优越性 。 然而 , 很少有人对它们进行恰当的比较——当研究人员设法把它们放在一起评估时 , 并没有明确的证据可以表明近 10 年来它们的性能有什么改善 。

本文最初发布于科学杂志 , 由 InfoQ 中文站翻译并分享 。

人工智能(AI)似乎变得越来越聪明 。 每一部 iPhone 都比上一部更了解你的脸、声音和习惯 , 人工智能对隐私的威胁也在不断增加 , 职位也在不断增加 。 这种激增反映了更快的芯片、更多的数据和更好的算法 。 但是 , 麻省理工学院的计算机科学研究生 Davis Blalock 说 , 有一些改进是来自微调 , 而不是发明者声称的核心创新 , 而有些改进可能根本就不存在 。 Blalock 和他的同事比较了几十种改进神经网络的方法(大致模仿大脑的软件架构) 。 他说 , “在研究了 50 篇论文之后 , 事情已经变得很清晰 , 当时的技术水平到底如何并不是一件显而易见的事情 。 ”

研究人员评估了 81 种剪枝算法、程序 , 它们通过对不需要的连接进行剪枝来提高神经网络的效率 。 这些方法差别不大 , 但所有人都宣称自己具有优越性 。 然而 , 很少有人对它们进行恰当的比较——当研究人员设法把它们放在一起评估时 , 并没有明确的证据可以表明近 10 年来它们的性能有什么改善 。 今年 3 月 , 在机器学习与系统大会上公布的这一结果让 Blalock 的博士生导师、麻省理工学院的计算机科学家 John Guttag 感到意外 , 他指出 , 这种无规则的对比本身就说明了技术发展的停滞 。 Guttag 说 , “老话说得好 , 无法度量就无法改进 , 对吧?”

研究人员逐渐意识到 , 人工智能的许多子领域的进展都出现了问题 。 2019 年开展的一项针对搜索引擎中使用的信息检索算法的元分析表明 , “最高点……实际上出现在 2009 年 。 ”2019 年的另一项研究再现了 7 个神经网络推荐系统 , 这类系统主要用于流媒体服务 。 研究发现 , 有六种算法的性能没有超过多年前开发的简单许多的非神经算法(这些早期的技术当时都经过了调优) , 揭示了该领域的“进展幻象” 。

今年 3 月 , 来自康奈尔大学的计算机科学家 Kevin Musgrave 在 arXiv 网站上发表了一篇论文 , 他研究了损失函数 , 这是这类算法的一部分 , 从数学上明确了算法的目标 。 Musgrave 在一项涉及图像检索的任务中 , 基于同样的标准对其中的 12 种方法进行了比较 , 结果发现 , 与开发人员的说法相反 , 准确性自 2006 年以来就再没有提高 。 Musgrave 说:“这一直以来都是炒作 。 ”

机器学习算法的性能增强可以来自其架构、损失函数或优化策略(如何使用反馈进行改进)的根本性变化 。 来自卡耐基梅隆大学的计算机科学家 Zico Kolter 表示 , 对上述任何一种技术进行细微的调整都可以提高性能 。 Kolter 的研究内容是经过训练后能够对黑客的“对抗性攻击”免疫的图像识别模型 。 一种被称为投影梯度下降(PGD)的早期对抗性训练方法(该方法会同时在真假样例上进行简单的训练) , 似乎已经被更复杂的方法所超越 。 但在今年 2 月 arXiv 发表的一篇论文中 , Kolter 和他的同事们发现 , 当使用一个简单的技巧来对它们进行增强时 , 所有方法的效果都差不多 。

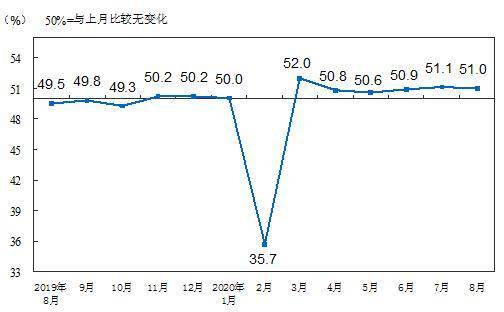

本文插图

在经过适度调整后 , 旧的图像检索算法和新算法的性能一样好 , 这表明 , 实际的创新很少 。

“这非常令人惊讶 , 这一点我们以前没有发现 , ”Kolter 的博士生 Leslie Rice 说 。 而 Kolter 表示 , 他的发现表明 , 像 PGD 这样的创新很难做到 , 而且很少有实质性的改进 。 “很明显 , PGD 实际上就是一种正确的算法 , ”他说 , “这显而易见 , 而人们希望找到更为复杂的解决方案 。 ”

推荐阅读

- 技术编程|如何利用数据库进行世界史研究

- 环球Tech|室内飞无人机担心互撞?研究人员开发AI算法来防撞

- 春光研究院|兼具家用和车载,售价只要竞品零头!洒哇地咔K11吸尘器开箱评

- 科学|如果欧洲核子研究中心发现了一种新的粒子,这意味着什么呢?

- 戒毒|防治毒品复吸新靶点 研究团队“擦除”小鼠成瘾记忆

- 科学|2020年蝗虫频繁来袭,研究发现,它们在向人类传达重要信息

- 电脑使用技巧|写论文要注意什么问题?

- 青年|ICML 2020论文贡献榜排名出炉:Google单挑斯坦福、MIT、伯克利;清华进TOP 20

- 交通|深圳北斗应用技术研究院斩获2020红点奖

- 互联网|美林数据:参与组建国内首个省级泛在电力物联网工程研究中心