гҖҺ黑马зЁӢеәҸе‘ҳгҖҸзҪ‘з»ңжЁЎеһӢжқҘйҫҷеҺ»и„үпјҢKubernetes( дәҢ )

ж–Үз« еӣҫзүҮ

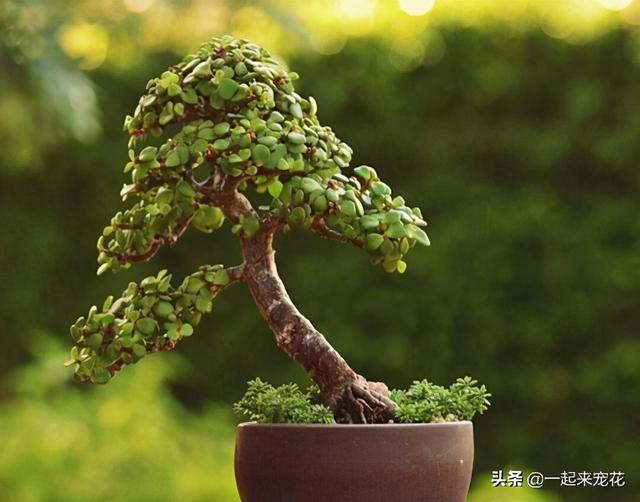

иҝҷдёӘж–№жЎҲзҡ„зІҫй«“еңЁдәҺrouteиЎЁзҡ„и®ҫзҪ® пјҢ еҰӮдёҠеӣҫжүҖзӨә гҖӮ жҺҘдёӢжқҘдёәеӨ§е®¶дёҖдёҖи§ЈиҜ»дёҖдёӢ гҖӮ

第дёҖжқЎеҫҲз®ҖеҚ• пјҢ жҲ‘们еңЁи®ҫзҪ®зҪ‘еҚЎзҡ„ж—¶еҖҷйғҪдјҡеҠ дёҠиҝҷдёҖиЎҢ гҖӮ е°ұжҳҜжҢҮе®ҡжҲ‘зҡ„й»ҳи®Өи·Ҝз”ұжҳҜйҖҡиҝҮе“ӘдёӘIPиө°жҺү пјҢ й»ҳи®Өи®ҫеӨҮеҸҲжҳҜд»Җд№Ҳпјӣ第дәҢжқЎжҳҜеҜ№Subnetзҡ„дёҖдёӘ规еҲҷеҸҚйҰҲ гҖӮ е°ұжҳҜиҜҙжҲ‘зҡ„иҝҷдёӘзҪ‘ж®өжҳҜ10.244.0.0 пјҢ жҺ©з ҒжҳҜ24дҪҚ пјҢ е®ғзҡ„зҪ‘е…іең°еқҖе°ұеңЁзҪ‘жЎҘдёҠ пјҢ д№ҹе°ұжҳҜ10.244.0.1 гҖӮ иҝҷе°ұжҳҜиҜҙиҝҷдёӘзҪ‘ж®өзҡ„жҜҸдёҖдёӘеҢ…йғҪеҸ‘еҲ°иҝҷдёӘзҪ‘жЎҘзҡ„IPдёҠпјӣ第дёүжқЎжҳҜеҜ№еҜ№з«Ҝзҡ„дёҖдёӘеҸҚйҰҲ гҖӮ еҰӮжһңдҪ зҡ„зҪ‘ж®өжҳҜ10.244.1.0пјҲдёҠеӣҫеҸіиҫ№зҡ„Subnetпјү пјҢ жҲ‘们е°ұжҠҠе®ғзҡ„Hostзҡ„зҪ‘еҚЎдёҠзҡ„IP(10.168.0.3)дҪңдёәзҪ‘е…і гҖӮ д№ҹе°ұжҳҜиҜҙ пјҢ еҰӮжһңж•°жҚ®еҢ…жҳҜеҫҖ10.244.1.0иҝҷдёӘзҪ‘ж®өеҸ‘зҡ„ пјҢ е°ұиҜ·д»Ҙ10.168.0.3дҪңдёәзҪ‘е…і гҖӮеҶҚжқҘзңӢдёҖдёӢиҝҷдёӘж•°жҚ®еҢ…еҲ°еә•жҳҜеҰӮдҪ•и·‘иө·жқҘзҡ„пјҹ

еҒҮи®ҫе®№еҷЁ(10.244.0.2)жғіиҰҒеҸ‘дёҖдёӘеҢ…з»ҷ10.244.1.3 пјҢ йӮЈд№Ҳе®ғеңЁжң¬ең°дә§з”ҹдәҶTCPжҲ–иҖ…UDPеҢ…д№ӢеҗҺ пјҢ еҶҚдҫқж¬ЎеЎ«еҘҪеҜ№з«ҜIPең°еқҖгҖҒжң¬ең°д»ҘеӨӘзҪ‘зҡ„MACең°еқҖдҪңдёәжәҗMACд»ҘеҸҠеҜ№з«ҜMAC гҖӮ дёҖиҲ¬жқҘиҜҙжң¬ең°дјҡи®ҫе®ҡдёҖжқЎй»ҳи®Өи·Ҝз”ұ пјҢ й»ҳи®Өи·Ҝз”ұдјҡжҠҠcni0дёҠзҡ„IPдҪңдёәе®ғзҡ„й»ҳи®ӨзҪ‘е…і пјҢ еҜ№з«Ҝзҡ„MACе°ұжҳҜиҝҷдёӘзҪ‘е…ізҡ„MACең°еқҖ гҖӮ 然еҗҺиҝҷдёӘеҢ…е°ұеҸҜд»ҘеҸ‘еҲ°жЎҘдёҠеҺ»дәҶ гҖӮ еҰӮжһңзҪ‘ж®өеңЁжң¬жЎҘдёҠ пјҢ йӮЈд№ҲйҖҡиҝҮMACеұӮзҡ„дәӨжҚўеҚіеҸҜи§ЈеҶі гҖӮ

иҝҷдёӘдҫӢеӯҗдёӯжҲ‘们зҡ„IP并дёҚеұһдәҺжң¬зҪ‘ж®ө пјҢ еӣ жӯӨзҪ‘жЎҘдјҡе°Ҷе…¶дёҠйҖҒеҲ°дё»жңәзҡ„еҚҸи®®ж ҲеҺ»еӨ„зҗҶ гҖӮ дё»жңәеҚҸи®®ж ҲжҒ°еҘҪжүҫеҲ°дәҶеҜ№з«Ҝзҡ„MACең°еқҖ гҖӮ дҪҝз”Ё10.168.0.3дҪңдёәе®ғзҡ„зҪ‘е…і пјҢ йҖҡиҝҮжң¬ең°ARPжҺўжҹҘеҗҺ пјҢ жҲ‘们еҫ—еҲ°дәҶ10.168.0.3зҡ„MACең°еқҖ гҖӮ еҚійҖҡиҝҮеҚҸи®®ж ҲеұӮеұӮз»„иЈ… пјҢ жҲ‘们иҫҫеҲ°дәҶзӣ®зҡ„ пјҢ е°ҶDst-MACеЎ«дёәеҸіеӣҫдё»жңәзҪ‘еҚЎзҡ„MACең°еқҖ пјҢ д»ҺиҖҢе°ҶеҢ…д»Һдё»жңәзҡ„eth0еҸ‘еҲ°еҜ№з«Ҝзҡ„eth0дёҠеҺ» гҖӮ

жүҖд»ҘеӨ§е®¶еҸҜд»ҘеҸ‘зҺ° пјҢ иҝҷйҮҢжңүдёҖдёӘйҡҗеҗ«зҡ„йҷҗеҲ¶ пјҢ дёҠеӣҫдёӯзҡ„MACең°еқҖеЎ«еҘҪд№ӢеҗҺдёҖе®ҡжҳҜиғҪеҲ°иҫҫеҜ№з«Ҝзҡ„ пјҢ дҪҶеҰӮжһңиҝҷдёӨдёӘе®ҝдё»жңәд№Ӣй—ҙдёҚжҳҜдәҢеұӮиҝһжҺҘзҡ„ пјҢ дёӯй—ҙз»ҸиҝҮдәҶдёҖдәӣзҪ‘е…ігҖҒдёҖдәӣеӨҚжқӮзҡ„и·Ҝз”ұ пјҢ йӮЈд№ҲиҝҷдёӘMACе°ұдёҚиғҪзӣҙиҫҫ пјҢ иҝҷз§Қж–№жЎҲе°ұжҳҜдёҚиғҪз”Ёзҡ„ гҖӮ еҪ“еҢ…еҲ°иҫҫдәҶеҜ№з«Ҝзҡ„MACең°еқҖд№ӢеҗҺ пјҢ еҸ‘зҺ°иҝҷдёӘеҢ…зЎ®е®һжҳҜз»ҷе®ғзҡ„ пјҢ дҪҶжҳҜIPеҸҲдёҚжҳҜе®ғиҮӘе·ұзҡ„ пјҢ е°ұејҖе§ӢForwardжөҒзЁӢ пјҢ еҢ…дёҠйҖҒеҲ°еҚҸи®®ж Ҳ пјҢ д№ӢеҗҺеҶҚиө°дёҖйҒҚи·Ҝз”ұ пјҢ еҲҡеҘҪдјҡеҸ‘зҺ°10.244.1.0/24йңҖиҰҒеҸ‘еҲ°10.244.1.1иҝҷдёӘзҪ‘е…ідёҠ пјҢ д»ҺиҖҢеҲ°иҫҫдәҶcni0зҪ‘жЎҘ пјҢ е®ғдјҡжүҫеҲ°10.244.1.3еҜ№еә”зҡ„MACең°еқҖ пјҢ еҶҚйҖҡиҝҮжЎҘжҺҘжңәеҲ¶ пјҢ иҝҷдёӘеҢ…е°ұеҲ°иҫҫдәҶеҜ№з«Ҝе®№еҷЁ гҖӮ

еӨ§е®¶еҸҜд»ҘзңӢеҲ° пјҢ ж•ҙдёӘиҝҮзЁӢжҖ»жҳҜдәҢеұӮгҖҒдёүеұӮ пјҢ еҸ‘зҡ„ж—¶еҖҷеҸҲеҸҳжҲҗдәҢеұӮ пјҢ еҶҚеҒҡи·Ҝз”ұ пјҢ е°ұжҳҜдёҖдёӘеӨ§зҺҜеҘ—е°ҸзҺҜ гҖӮ иҝҷжҳҜдёҖдёӘжҜ”иҫғз®ҖеҚ•зҡ„ж–№жЎҲ пјҢ еҰӮжһңдёӯй—ҙиҰҒиө°йҡ§йҒ“ пјҢ еҲҷеҸҜиғҪдјҡжңүдёҖжқЎvxlantunnelзҡ„и®ҫеӨҮ пјҢ жӯӨж—¶е°ұдёҚеЎ«зӣҙжҺҘзҡ„и·Ҝз”ұ пјҢ иҖҢеЎ«жҲҗеҜ№з«Ҝзҡ„йҡ§йҒ“еҸ· гҖӮ

Service究з«ҹеҰӮдҪ•е·ҘдҪң

Serviceе…¶е®һжҳҜдёҖз§ҚиҙҹиҪҪеқҮиЎЎ(LoadBalance)зҡ„жңәеҲ¶ гҖӮ

жҲ‘们и®Өдёәе®ғжҳҜдёҖз§Қз”ЁжҲ·дҫ§(ClientSide)зҡ„иҙҹиҪҪеқҮиЎЎ пјҢ д№ҹе°ұжҳҜиҜҙVIPеҲ°RIPзҡ„иҪ¬жҚўеңЁз”ЁжҲ·дҫ§е°ұе·Із»Ҹе®ҢжҲҗдәҶ пјҢ 并дёҚйңҖиҰҒйӣҶдёӯејҸең°еҲ°иҫҫжҹҗдёҖдёӘNGINXжҲ–иҖ…жҳҜдёҖдёӘELBиҝҷж ·зҡ„组件жқҘиҝӣиЎҢеҶізӯ– гҖӮ

ж–Үз« еӣҫзүҮ

е®ғзҡ„е®һзҺ°жҳҜиҝҷж ·зҡ„пјҡйҰ–е…ҲжҳҜз”ұдёҖзҫӨPodз»„жҲҗдёҖз»„еҠҹиғҪеҗҺз«Ҝ пјҢ еҶҚеңЁеүҚз«ҜдёҠе®ҡд№үдёҖдёӘиҷҡIPдҪңдёәи®ҝй—®е…ҘеҸЈ гҖӮ дёҖиҲ¬жқҘиҜҙ пјҢ з”ұдәҺIPдёҚеӨӘеҘҪи®° пјҢ жҲ‘们иҝҳдјҡйҷ„иө дёҖдёӘDNSзҡ„еҹҹеҗҚ пјҢ Clientе…Ҳи®ҝй—®еҹҹеҗҚеҫ—еҲ°иҷҡIPд№ӢеҗҺеҶҚиҪ¬жҲҗе®һIP гҖӮ Kube-proxyеҲҷжҳҜж•ҙдёӘжңәеҲ¶зҡ„е®һзҺ°ж ёеҝғ пјҢ е®ғйҡҗи—ҸдәҶеӨ§йҮҸзҡ„еӨҚжқӮжҖ§ гҖӮ е®ғзҡ„е·ҘдҪңжңәеҲ¶жҳҜйҖҡиҝҮapiserverзӣ‘жҺ§Pod/Serviceзҡ„еҸҳеҢ–пјҲжҜ”еҰӮжҳҜдёҚжҳҜж–°еўһдәҶServiceгҖҒPodпјү并е°Ҷе…¶еҸҚйҰҲеҲ°жң¬ең°зҡ„规еҲҷжҲ–иҖ…жҳҜз”ЁжҲ·жҖҒиҝӣзЁӢ гҖӮ

дёҖдёӘLVSзүҲзҡ„ServiceжҲ‘们жқҘе®һйҷ…еҒҡдёҖдёӘLVSзүҲзҡ„Service гҖӮ LVSжҳҜдёҖдёӘдё“й—Ёз”ЁдәҺиҙҹиҪҪеқҮиЎЎзҡ„еҶ…ж ёжңәеҲ¶ гҖӮ е®ғе·ҘдҪңеңЁз¬¬еӣӣеұӮ пјҢ жҖ§иғҪдјҡжҜ”з”Ёiptableе®һзҺ°еҘҪдёҖдәӣ гҖӮ

еҒҮи®ҫжҲ‘们жҳҜдёҖдёӘKube-proxy пјҢ жӢҝеҲ°дәҶдёҖдёӘServiceзҡ„й…ҚзҪ® пјҢ еҰӮдёӢеӣҫжүҖзӨәпјҡе®ғжңүдёҖдёӘClusterIP пјҢ еңЁиҜҘIPдёҠзҡ„з«ҜеҸЈжҳҜ9376 пјҢ йңҖиҰҒеҸҚйҰҲеҲ°е®№еҷЁдёҠзҡ„жҳҜ80з«ҜеҸЈ пјҢ иҝҳжңүдёүдёӘеҸҜе·ҘдҪңзҡ„Pod пјҢ е®ғ们зҡ„IPеҲҶеҲ«жҳҜ10.1.2.3,10.1.14.5,10.1.3.8 гҖӮ

жҺЁиҚҗйҳ…иҜ»

- е·Ҙдёҡдә’иҒ”зҪ‘@зЁӢеәҸе‘ҳзҡ„жңҜдёҺйҒ“пјҡжңҜвҖ”вҖ”зј–зЁӢеҹәжң¬еҠҹд№ӢзҪ‘з»ңзј–зЁӢ

- 科жҠҖжӣ°жҠҘжІҲйғҺд№Ў дҫ еӨ©дёӢ зҪ‘зәўйӨҗеҺ…жұӨзі»зҒ«й”… е°ӨжәӘжЎӮеі°4AжҷҜеҢәпјҢеҮӨж§ҝзҪ‘з»ң

- гҖҢе®ўжҲ·з«ҜгҖҚеӯҰд№ зҪ‘з»ңзј–зЁӢпјҢдёҚдәҶи§ЈTCPеҚҸи®®пјҹйҡҫжҖӘйқўиҜ•иў«еҲ·дёӢеҺ»пјҢиҝҳдёҚжқҘеӯҰд№ пјҒ

- зІҫйҖүзғӯзӮ№иө„и®ҜжІҲйҳіеёӮжІҲжІіеҢәпјҡзҪ‘з»ңзӣҙж’ӯеҠ©зҺ°д»Је•ҶиҙёдёҡиҪ¬еһӢеҚҮзә§

- жҺЁе“Ҙ科жҠҖзҲҶж–ҷжңҖеӨ§й»‘马дә®еү‘пјҒпјҢ5GжүӢжңәжҖ§д»·жҜ”TOP10пјҡе°Ҹзұі10ж— зјҳ

- зҒ«з§‘жҠҖзңӢзңӢе“ӘдёҖж¬ҫжҳҜдҪ жңҖзҲұзҡ„пјҢеӣҪдә§ж–°еӣӣеӨ§5GзҪ‘з»ңж——иҲ°жүӢжңәе…ЁйғЁеҸ‘еёғ

- PythonзҲұеҘҪиҖ…зӨҫеҢә| зЁӢеәҸе‘ҳйҖҶеӨ©ж”№е‘ҪпјҢжј«з”»

- жүӢжңәеӨ§йӯ”зҺӢiPhone8и·ҢиҮіеҶ°зӮ№д»·жҸҗеүҚз ёеңәпјҢе…Ёзі»OLED+5GзҪ‘з»ңiPhone12жӣқе…ү

- InfoQ8 е№ҙпјҢеҸӘдёәдёӢиҪҪеҠЁжј«и§Ҷйў‘пјҢдәҢж¬Ўе…ғвҖңдёӯжҜ’вҖқжӮЈиҖ…пјҹдёҖй»‘е®ўж“Қзәөеғөе°ёзҪ‘з»ң

- йӣ·еҶӣв– зЁӢеәҸе‘ҳиҫһеҺ»дә’иҒ”зҪ‘е·ҘдҪңпјҢи·ЁиЎҢеҺ»дј з»ҹдёҠеёӮе…¬еҸёпјҢз»“жһңдёҠзҸӯ第1еӨ©е°ұи’ҷдәҶ

![[з”өеӯҗе•ҶеҠЎ]马дә‘еҸҲдёҖйў„иЁҖжҲҗзңҹпјҹ2020е№ҙжңҖиөҡй’ұзҡ„дёҚжҳҜжҲҝең°дә§пјҢиҖҢжҳҜиҝҷдёүдёӘиЎҢдёҡ](http://img88.010lm.com/img.php?https://image.uc.cn/s/wemedia/s/2020/84275620325d46b6c1ee28e809d3002f.jpg)